Un brazo robótico virtual logra enseñar a otro a resolver distintas tareas

Gracias a un juego diseñado para que ambos intentaran ser más astutos que el otro, uno aprendió a afrontar una gran variedad de objetivos, desde poner la mesa hasta colocar las piezas de un tablero de ajedrez sin tener que entrenarse para cada tarea. Ahora falta traspasar este avance al mundo real

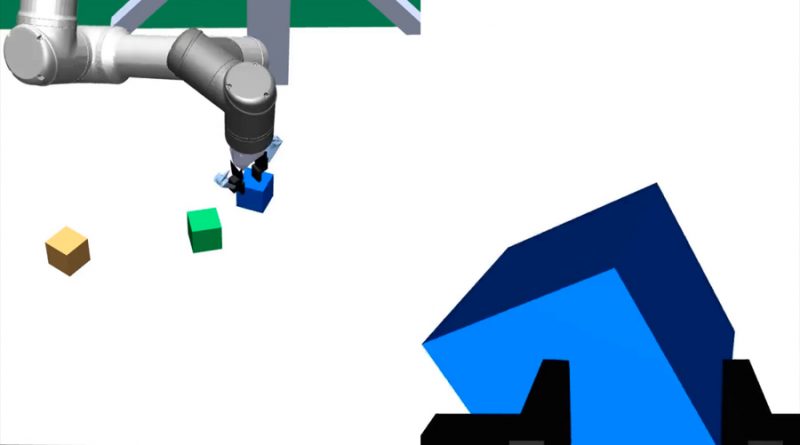

Un brazo robótico virtual ha aprendido a resolver una amplia variedad de rompecabezas diferentes (apilar bloques, poner la mesa, colocar las piezas de ajedrez) sin tener que volver a entrenarse para cada tarea concreta. Para lograrlo, se dedicó a jugar contra otro brazo robótico entrenado para desafiarlo de una forma cada vez más difícil.

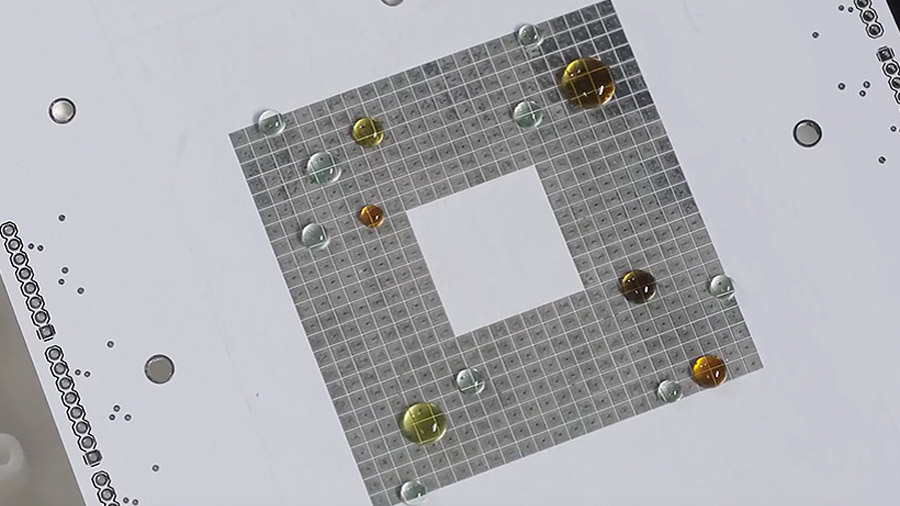

Autojuego: dos brazos robóticos idénticos, Alicia y Roberto, desarrollados por investigadores de OpenAI, aprenden jugando entre ellos en un entorno simulado, sin intervención humana. Los robots utilizan aprendizaje reforzado, en el que los sistemas de inteligencia artificial (IA) se entrenan mediante ensayo y error sobre qué acciones tomar en diferentes situaciones para lograr ciertos objetivos. El juego consiste en mover objetos sobre una mesa virtual. Al ordenar los objetos de formas concretas, Alicia intenta proponer tareas que a Roberto le resulten difíciles de realizar. Roberto trata de resolver las tareas de Alicia. A medida que aprenden, Alicia formula problemas cada vez más complejos y Roberto los soluciona cada vez mejor.

Multitarea: los modelos de aprendizaje profundo generalmente se tienen que volver a entrenar para abordar cada tarea. Por ejemplo, AlphaZero (que también aprende jugando contra sí mismo) utiliza un solo algoritmo para enseñarse a sí mismo a jugar al ajedrez, shogi y Go, pero solo puede hacerlo con un juego a la vez. El AlphaZero que sabe jugar al ajedrez no sabe cómo jugar al Go y el que juega al Go no es capaz de jugar al shogi. Construir máquinas realmente capaces de realizar múltiples tareas es un gran tema sin solucionar en el camino hacia una IA más general.

Dojo de IA: uno de los problemas consiste en que entrenar a una IA para realizar múltiples tareas requiere una gran cantidad de ejemplos. OpenAI lo evita entrenando a Alicia para que genere los ejemplos para Roberto, es decir, se usa una IA para entrenar a otra. Alicia aprendió a establecer metas como construir una torre de bloques, luego levantarla y balancearla. Roberto aprendió a utilizar las propiedades del entorno (virtual), como la fricción, además de agarrar y girar los objetos.

Realidad virtual: hasta ahora, este enfoque solo se ha probado en un entorno simulado, pero los investigadores de OpenAI y otros lugares están mejorando las formas de transferir los modelos entrenados en entornos virtuales a entornos físicos. La simulación permite que los sistemas de IA analicen grandes conjuntos de datos en un corto período de tiempo, antes de adaptarlo todo a las condiciones del mundo real.

El objetivo general: los investigadores afirman que su meta final es entrenar a un robot para que resuelva cualquier tarea que una persona pueda pedirle. Al igual que el modelo de lenguaje GPT-3, capaz de usar el lenguaje en una gran variedad de formas diferentes, estos brazos robóticos son parte de la ambición general de OpenAI de crear una IA multitarea. Usar una IA para entrenar a otra podría ser una parte clave de ese propósito.

Fuente: technologyreview.es