Crear noticias falsas, al alcance de cualquiera gracias a la IA

¿Saben qué? Acabo de ver un vídeo embarazoso del senador estadounidense Ted Cruz cantando y bailando con música de Tina Turner. Sus enemigos políticos se divertirán mucho mostrándolo en esta mitad de la legislatura de gobierno. Donald Trump le llamará “Ted, el bailarín”.

Vale, lo admito, yo mismo he creado el vídeo. Pero lo que resulta preocupante es que haya requerido muy poca habilidad para editarlo. Descargué y configuré un software que usa el aprendizaje automático para realizar un convincente cambio digital de rostro. El montaje resultante, conocido como deepfake, muestra los ojos caídos inconfundibles de Cruz unidos a los rasgos del actor Paul Rudd cantando karaoke. No es perfecto. Se nota algo un poco raro, pero podría engañar a alguien.

La manipulación fotográfica no es nueva, pero la inteligencia artificial cambiará ese juego por completo. Hasta hace poco, solo un estudio cinematográfico de gran presupuesto podía llevar a cabo un vídeo intercambiando rostros, y probablemente hubiera costado millones de dólares. Ahora la IA facilita a cualquiera con un ordenador decente y unas horas de sobra a que consiga lo mismo. Los avances adicionales en el aprendizaje automático crearán farsas todavía más complejas y harán que resulte más complicado detectar la mentira.

Estos avances amenazan con desdibujar aún más la línea entre la verdad y la ficción en la política. Internet ya acelera y refuerza la difusión de la desinformación a través de cuentas falsas en redes sociales.Los “datos alternativos” y las teorías de conspiración son comunes y generalmente creíbles. Las noticias falsas, además de haber influido en las últimas elecciones presidenciales de EE. UU, desencadenaron la violencia étnica en Myanmar y Sri Lanka durante el pasado año. Habrá que imaginar qué pasará si se unen con los nuevos tipos de vídeos falsos que parecen reales. Los políticos diciendo tonterías o insultos racistas, o comportándose de manera inapropiada. Solo que, en realidad, lo que aparece en esos vídeos jamás sucedió.

“Los deepfakes podrían desestabilizar el discurso político”, comenta el profesor de la Universidad de Nueva York y autor de Virtual Unreality: Just Because the Internet Told You, How Do You Know It’s True? Charles Seife. Seife confiesa que le asombra lo rápido que han progresado las cosas desde que se publicó su libro, en 2014. “La tecnología altera nuestra percepción de la realidad a un ritmo alarmante”, afirma.

¿Estamos a punto de entrar en una época en la que no podremos confiar en nada? ¿Tampoco podremos creernos las imágenes que parecen auténticas y que muestran verdaderas noticias? ¿Cómo decidimos qué es creíble? ¿De quién fiarnos?

Una verdadera falsedad

Varias tecnologías se han unido para crear el engaño y son bastante accesibles. Los teléfonos inteligentes permiten a cualquiera grabar un vídeo y las poderosas herramientas gráficas en los ordenadores se han vuelto mucho más económicas. A eso se le añade el software de inteligencia artificial, que permite distorsionar, mezclar y sintetizar de forma extraordinaria. La IA no es solo una mejor versión de Photoshop o iMovie. También facilita que un ordenador aprenda el aspecto y el sonido del mundo para idear copias convincentes.

Yo creé el clip de Cruz usando OpenFaceSwap, uno de los varios programas de intercambio de rostros que se descargan gratis. Se requiere un ordenador con una memoria gráfica avanzada, que cuesta unos pocos miles de dólares. Pero también resulta posible alquilar el acceso a una máquina virtual por escasos centavos por minuto y usar una plataforma de aprendizaje automático en la nube como por ejemplo Paperspace. Después, simplemente, se introducen los dos vídeos y durante unas horas un algoritmo descubre qué aspecto tiene cada cara y cómo se mueve para luego trazar un rostro sobre el otro. Ponerlo en marcha requiere un poco de destreza. Si se eligen vídeos muy diferentes, el resultado puede ser una terrible mezcla de narices, orejas y barbillas.

Pero el proceso resulta bastante fácil.

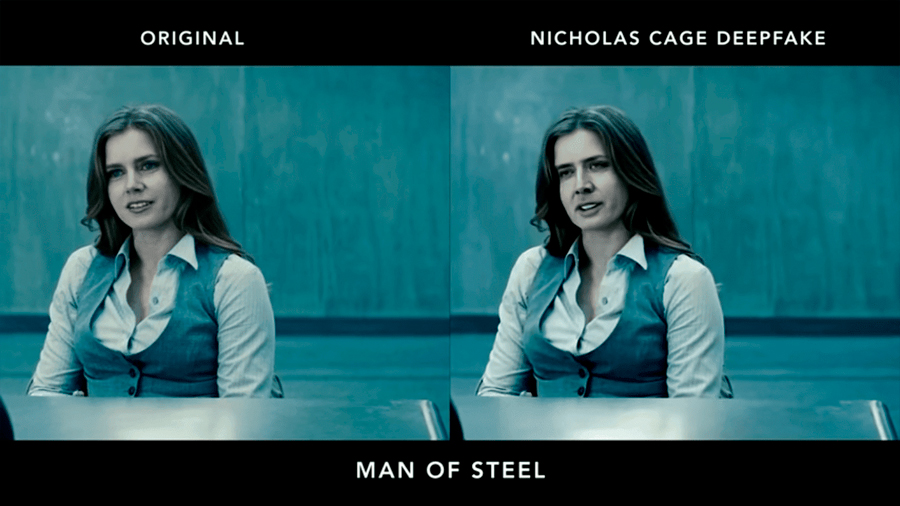

El intercambio de rostros primero fue usado para hacer porno, como era de prever. En 2017, un usuario anónimo de Reddit, conocido como Deepfakes,utilizó el aprendizaje automático para intercambiar rostros de actrices famosas con estrellas de películas para adultos, en algunas escenas, y luego publicó los resultados en un subreddit dedicado a filtrar porno con celebridades. Otro usuario de Reddit lanzó después una interfaz fácil de usar, que condujo a una proliferación de deepfake porno, como también, por alguna extraña razón, de los vídeos interminables del actor Nicolas Cage en películas en las que no actuaba. Incluso Reddit, un sitio muy libre, prohibió esa pornografía no consentida. Sin embargo, el fenómeno persiste en los rincones oscuros de Internet.

OpenFaceSwap utiliza una red artificial de neuronas, la herramienta de referencia en la IA. Las redes neuronales muy grandes o profundas, que se alimentan con enormes cantidades de datos de aprendizaje, son capaces de realizar todo tipo de cosas útiles, incluida la búsqueda de la cara de una persona entre millones de imágenes. También se pueden emplear para manipular y sintetizar imágenes.

OpenFaceSwap enseña a una red profunda como “codificar” un rostro (un proceso similar a la compresión de datos), creando así una reproducción que puede decodificarse para reconstruirlo completamente. El truco consiste en alimentar los datos codificados con una cara más en el decodificador de la otra. La red neuronal conjurará, a menudo con sorprendente precisión, una imagen que imita las expresiones y movimientos de la otra. El vídeo resultante puede parecer poco claro, pero OpenFaceSwap borrará automáticamente los bordes y ajustará el color de la cara recién trasplantada para que se vea más auténtica.

Una tecnología similar serviría para recrear la voz de otra persona. Una start-up llamada Lyrebird ha publicado muestras convincentes de Barack Obama y Donald Trump diciendo cosas completamente inventadas. Lyrebird confirma que en el futuro limitará sus duplicados de voz a personas que hayan dado su permiso, pero seguramente no todos serán tan escrupulosos.

Existen métodos bien establecidos para identificar imágenes y vídeos adulterados. Una opción sería buscar imágenes en la web que podrían haber sido mezcladas. Otra solución más técnica consiste en rastrear indicadores de cambios en un archivo digital, o en los píxeles de una imagen o de un marco de vídeo. Un experto puede escarbar incoherencias visuales: una sombra que no debería estar allí o un objeto de un tamaño inadecuado.

Uno de los principales expertos del mundo, Hany Farid, de la Universidad de Dartmouth, ha mostrado cómo reconstruir una escena en 3-D para descubrir rarezas físicas. También ha demostrado que los cambios sutiles en la intensidad del píxel en un vídeo, que indican el ritmo cardíaco de una persona, detectarían la diferencia entre una persona real y una creada por un ordenador. Recientemente uno de los antiguos alumnos de Farid, ahora profesor en la Universidad Estatal de Nueva York en Albany, ha señalado que el parpadeo irregular de los ojos revelaría una cara manipulada por la inteligencia artificial.

No obstante, la mayoría de la gente no puede hacer este trabajo de detective y no tiene tiempo para estudiar cada imagen o vídeo que aparece en Facebook. Por eso, a medida que la farsa visual se ha vuelto más común, se avanza en automatizar el análisis. Y resulta que el aprendizaje profundo no solo es excelente para inventar cosas, sino que es ideal para analizar imágenes y vídeos en busca de indicios de falsedad. Sin embargo, este esfuerzo apenas acaba de comenzar y, en última instancia, lo complicará el nivel de realismo que alcanzará la falsificación automática.

Redes de engaño

Una de las ideas más novedosas en la investigación sobre IA consiste en volver las redes neuronales contra sí mismas para producir falsedades aún más creíbles. Una “red generativa antagónica”, o GAN (generative adversarial network, por sus siglas en inglés), usa dos redes neuronales profundas: una que ha sido entrenada para identificar imágenes o vídeos reales, y otra que con el tiempo aprende a burlar a su contraparte. Las GAN se entrenan para producir imágenes falsas sorprendentemente veraces.

Más allá de copiar e intercambiar rostros, las GAN podrían sintetizar escenas enteras y personas que parecen bastante reales, convirtiendo una escena diurna en una nocturna y creando celebridades imaginarias. Las GAN no funcionan a la perfección, pero mejoran continuamente, y representan un área de investigación muy interesante (MIT Technology Review nombró a GAN una de sus 10 tecnologías emergentes para 2018).

Lo más preocupante reside en que esta técnica también podría usarse para evadir el análisis forense digital. La Agencia de Proyectos de Investigación Avanzada de Defensa de EE. UU. invitó a los investigadores a participar este verano en una competición en la que algunos de ellos desarrollaban vídeos falsos utilizando GAN y otros intentaban detectarlos. “Las GAN son un desafío particular para nosotros en la comunidad forense porque podrían volverse contra nuestras técnicas forenses”, dice Farid. “Queda por ver qué lado prevalecerá”.

Esto es el fin

Si no tenemos cuidado, esto acabaría en el fin del mundo o, al menos, en lo más parecido.

En abril, un supuesto boletín de noticias de la BBC anunció el inicio de un conflicto nuclear entre Rusia y la OTAN. El vídeo, que comenzó a circular en la plataforma de mensajería WhatsApp, mostraba imágenes de misiles despegando mientras un locutor decía a los espectadores que la ciudad alemana de Mainz había sido destruida junto con algunas zonas de Frankfurt.

Era, por supuesto, completamente falso, y la BBC lo denunció rápidamente. El vídeo no se generó usando IA, pero sí que mostró la fuerza de un vídeo falso y la enorme velocidad de la difusión de los rumores. La proliferación de programas de IA contribuirá a que estos se produzcan de forma mucho más fácil, y aún parecerán más convincentes.

Incluso si las noticias falsas no nos engañan a nosotros, afectarán gravemente el debate político. Así como ahora estamos acostumbrados a cuestionar si una fotografía podría haber sido retocada en Photoshop, las falsedades generadas por IA nos motivarán a sospechar más sobre los acontecimientos que vemos compartidos online. Y esto podría contribuir a una mayor erosión del debate político racional.

En el libro The Death of Truth (La Muerte de la Verdad), publicado este año, la crítica literaria Michiko Kakutani argumenta que los datos alternativos, las noticias falsas y la locura general de la política moderna representan la culminación de las corrientes culturales que se remontan a décadas. Kakutani ve las hiperreales falsedades de IA como el último golpe fuerte al concepto de la realidad objetiva.

“Lo que es profundamente problemático, más que la tecnología que se ha vuelto tan buena, es el hecho de que exista y sea una forma de dañar la confianza en un material legítimo”, afirma la investigadora de Data for Democracy Renee DiResta, una de las primeras personas en identificar el fenómeno de las políticamente motivadas campañas de desinformación en Twitter.

Tal vez el mayor riesgo de esta nueva tecnología no resida en que la utilicen indebidamente los hackers del estado, los saboteadores políticos o Anonymous, sino que debilite aún más la verdad y la objetividad. Si no se distingue una verdad de una falsedad, entonces resulta fácil cuestionar la autenticidad de cualquier cosa. Esto ya sirve como una forma para los políticos a eludir la responsabilidad.

El presidente Trump ha dado la vuelta a la idea de las noticias falsas al usar el término atacar a cualquier noticia periodística que critique a su administración. También señaló que un vídeo incriminatorio de él denigrando a mujeres, lanzado durante la campaña de 2016, podría haber sido manipulado digitalmente. Este abril, el gobierno ruso acusó a Gran Bretaña de falsas pruebas de un ataque químico en Siria para justificar una acción militar. Ninguna de las acusaciones era cierta, pero la posibilidad de engaños sofisticados reduce cada vez más la credibilidad de la información real. En Myanmar y Rusia, una nueva legislación busca prohibir las noticias falsas, pero en ambos casos las leyes podrían servir simplemente como una manera de tomar medidas enérgicas contra las críticas al gobierno.

Considerando que los poderosos se vuelven cada vez más conscientes de las falsedades con IA, resultará fácil descartar cualquier prueba clara de malas conductas en vídeo diciendo que no se trata de nada más que de un engaño digital hecho por GAN.

La verdad todavía estará ahí afuera. ¿Pero la reconoceremos cuando la veamos?

Fuente: technologyreview.es