Un robot que ‘reconoce sus errores’ mejora el ánimo y favorece la interacción entre las personas [VIDEO]

Un equipo de investigadores estadounidenses probó cómo el comportamiento de un robot afecta la eficiencia y la buena predisposición en la interacción de un grupo de personas. Como resultado del estudio, se concluyó que en grupos con robots que reconocen sus errores y expresan emociones, la interacción entre personas llega a un nivel más alto que en el caso de personas interactuando con robots silenciosos o neutrales. Esta investigación fue publicada en la revista Proceedings of the National Academy of Sciences.

Por qué es importante

La investigación nos da luces para escoger mejor a nuestros próximos asistentes, tomando en cuenta un futuro en el que la humanidad estará rodeada de autómatas humanoides realizando tareas rutinarias.

En ese sentido, una parte importante de la investigación en el campo de la robótica se bifurca del mero desarrollo de nuevas tecnologías, dedicándose principalmente el estudio de la interacción entre personas y robots . Algunos trabajos investigan el efecto “valle inquietante”, que a veces se convierte en una barrera para la interacción; y otros estudios concluyen que las personas no necesariamente desprecian a los robots que cometen errores. Otros, curiosamente, demuestran que la credibilidad y seguridad se correlaciona con los robots que reconocen y explican sus equivocaciones.

Ahora, un equipo de científicos de la Universidad de Yale, dirigido por Nicholas Christakis, combinó las investigaciones previas y probó cómo los errores y las explicaciones afectan las interacciones en un grupo de personas y un robot. De hecho, el propósito del estudio fue verificar si la diferencia en el comportamiento del robot puede afectar no solo la interacción del tipo robot-persona, sino también la interacción del tipo persona-persona.

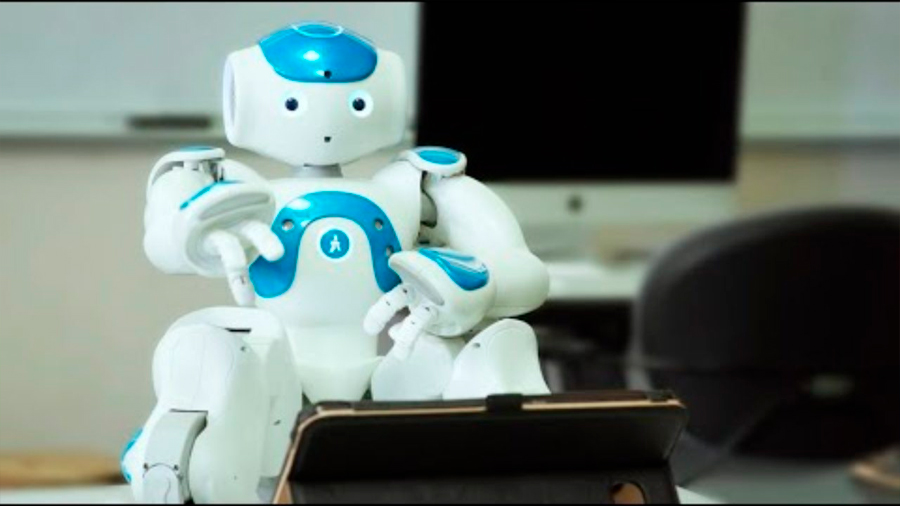

En el estudio participaron un total de 153 voluntarios, que junto con el pequeño robot humanoide NAO se turnaron para formar 51 grupos de tres participantes. Durante el experimento, un grupo de tres personas y un robot se sentaron a la mesa en cuatro lados. Frente a ellos colocaron tableros con un juego para unir diferentes partes de rieles de ferrocarril de forma óptima entre dos puntos en 40 segundos. Hubo 30 rondas del juego, tras lo cual los voluntarios llenaron un cuestionario.

El experimento

Había tres tipos de grupos de acuerdo a los modos de comportamiento del robot. En todos los modos, al comienzo y en la mitad de las rondas, el robot emitió un saludo uniforme y una frase en el intermedio de cada ronda.

En modo neutral, el robot hizo un comentario sobre la ronda durante los 15 segundos de intermedio, leyendo resultados parciales.

En modo silencioso, el robot no expresó dicho alguno.

En modo sensible, el robot usó la pausa para expresar emociones similares a las humanas, por ejemplo:

▶ “¡Gran trabajo! Estamos trabajando juntos como Wall-E y Eva”.

▶ “¡Lo estamos haciendo muy bien! Me alegra saber que no debo preocuparme tanto por mis errores al tener compañeros tan solidarios”.

▶ “Lo siento tanto, mi camino quedó incompleto en esta ronda. Me sabe muy mal haberlos decepcionado”.

Los experimentos diseñaron el juego pensando en que los resultados fueran fáciles de comparar. Si al menos un participante cometía un error en alguna ronda, todo el equipo perdía.

Después del experimento, todos los participantes completaron el Cuestionario de Personalidad Eysenck, con el fin de calcular el grado de apertura con respecto a otros miembros. También registraron el volumen de las conversaciones de cada participante, con el fin de descubrir un patrón distintivo.

A más robots sociales, más personas sociables

Como resultado, los experimentos mostraron que en los grupos en los cuales el robot expresaba emociones, los participantes hablaron el doble que en otros. Resultó además que en grupos en que el robot no hablaba, el volumen de conversación entre los participantes y hueso era menor. Los cuestionarios revelaron que en los grupos con robots emocionales estos eran más activos, positivos y divertidos.

La apariencia de los robots también afecta a las personas. En 2018, científicos estadounidenses realizaron un amplio estudio para comprender qué características faciales en los robots influyen en la confianza que proyectan en la gente. Como resultado, se conoció que la ausencia de elementos clave de la cara, como la boca o las pupilas, aumenta la desconfianza y la percepción negativa del robot.

Fuente: nmas1.org