Esta técnica entrena a la IA para que no se deje engañar

Los sistemas de reconocimiento y reconstrucción de imágenes continúan siendo vulnerables a ataques destinados a confundirlos. Un nuevo método ayuda a que el aprendizaje profundo falle menos enfrentando dos redes neuronales: una burla a otra, que mejora a su vez para evitar el engaño

El contexto: uno de los mayores defectos aún no resueltos del aprendizaje profundo consiste en su vulnerabilidad a los llamados ataques antagónicos. Cuando estas perturbaciones, aparentemente aleatorias o indetectables para el ojo humano, se introducen en un sistema de inteligencia artificial (IA), pueden provocar que las cosas salgan bastante mal. Unos adhesivos colocados estratégicamente en una señal de stop, por ejemplo, pueden engañar a un coche autónomo para que detecte una señal de límite de velocidad de 70 kilómetros por hora, mientras que otros adhesivos en una carretera pueden confundir a un Tesla para que se desvíe por el carril equivocado.

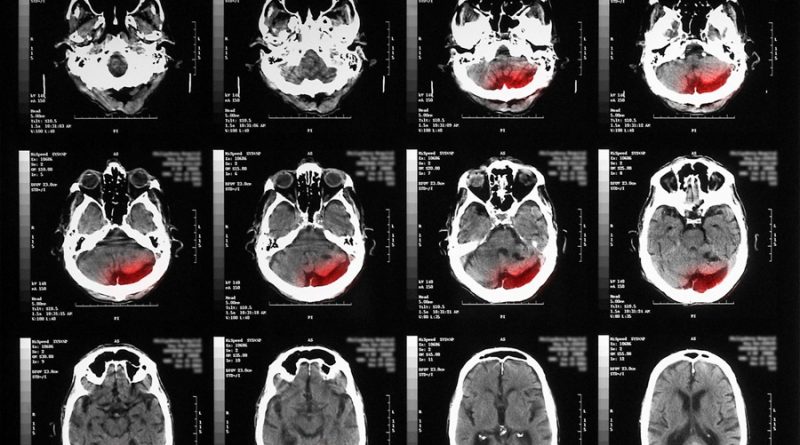

Seguridad crítica: la mayoría de las investigaciones de redes antagónicas se centran en los sistemas de reconocimiento de imágenes, pero los sistemas de reconstrucción de imágenes basados en el aprendizaje profundo también son vulnerables. Esto es un problema especialmente grave para la atención sanitaria, donde estos sistemas se suelen usar para reconstruir imágenes médicas como TAC o resonancias magnéticas a partir de los datos de rayos X. Un ataque antagónico dirigido podría provocar que dicho sistema reconstruya un tumor en una imagen donde no lo hay.

La investigación: una de las innovadoras menores de 35 años de MIT Technology Review de este año, Bo Li , y sus colegas de la Universidad de Illinois en Urbana-Champaign (EE. UU.) proponen ahora un nuevo método para entrenar a estos sistemas de aprendizaje profundo con el fin de que fallen menos y, por lo tanto, para que sean más confiables en escenarios críticos para la seguridad. Para ello, enfrentan a la red neuronal que se ocupa de la reconstrucción de la imagen con otra red neuronal responsable de generar ejemplos antagónicos, de forma similar a los algoritmos de las redes generativas antagónicas (GAN por sus siglas en inglés). A través de rondas iterativas, la red antagónica intenta engañar a la red de reconstrucción para que genere algo que no forma parte de los datos originales o de la verdad fundamental. La red de reconstrucción mejora continuamente para evitar ser engañada, por lo que resulta más seguro implementarla en el mundo real.

Los resultados: cuando los investigadores probaron su red neuronal entrenada de esta forma antagónica con dos populares conjuntos de datos de imágenes, fueron capaz de reconstruir la verdad fundamental mejor que otras redes neuronales que habían sido «entrenadas contra los fallos» con diferentes métodos. Sin embargo, los resultados aún no son perfectos, lo que demuestra que este método todavía necesita perfeccionarse más. Este trabajo se presentará la próxima semana en la Conferencia Internacional sobre Aprendizaje Automático.

Fuente: technologyreview.es