Singular chip de IA gigante ayudará a crear fármacos contra el cáncer

En el Laboratorio Nacional de Argonne, a aproximadamente 50 kilómetros del centro de Chicago (EE. UU.), los científicos intentan comprender el origen y la evolución del universo, crear baterías de mayor duración y desarrollar medicamentos de precisión contra el cáncer.

Todos estos problemas tan diferentes tienen algo en común: son complicados de resolver debido a su gran escala. Respecto al descubrimiento de medicamentos, se estima que podría haber más moléculas potencialmente similares a los medicamentos que átomos en el sistema solar. Buscar en un espacio de posibilidades tan enorme dentro de las escalas de tiempo humano requiere de una potente y rápida computación. Hasta hace poco, eso no estaba disponible, lo que hacía que la tarea fuera prácticamente insondable.

Sin embargo, en los últimos años la inteligencia artificial (IA) ha cambiado las reglas del juego. Los algoritmos de aprendizaje profundo son excelentes para encontrar rápidamente los patrones en una gran cantidad de datos, lo que ha acelerado los procesos clave del descubrimiento científico. Ahora, junto a estas mejoras de software, también está en el horizonte una revolución del hardware.

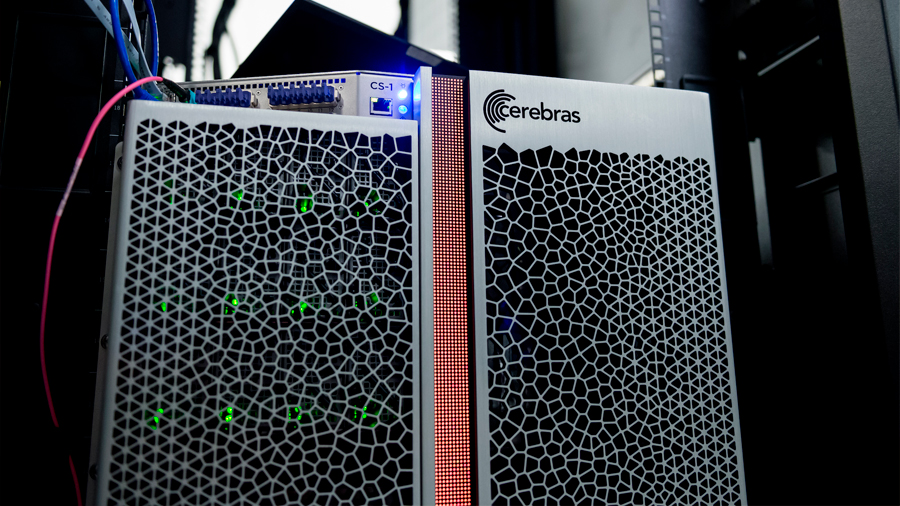

La semana pasada Argonne anunció que había empezado a probar un nuevo ordenador de la start-up Cerebras que promete acelerar el entrenamiento de algoritmos de aprendizaje profundo por órdenes de magnitud. El ordenador, que alberga el chip más grande del mundo, es parte de una nueva generación de hardware especializado en IA que solo acaba de empezar a usarse.

«Estamos interesados en acelerar las aplicaciones de IA que tenemos para los problemas científicos», afirma el director adjunto del laboratorio para informática, medio ambiente y ciencias de la vida, Rick Stevens. «Tenemos enormes cantidades de datos y grandes modelos, y queremos mejorar su rendimiento».

Actualmente, los chips más comunes utilizados en el aprendizaje profundo se conocen como unidades de procesamiento de gráficos o GPU. Las GPU son excelentes procesadores en paralelo. Antes de aplicarlos en el mundo de la IA, han sido ampliamente utilizados para juegos y producción gráfica. Casualmente, las mismas características que les permiten renderizar píxeles de forma rápida también son los que las convierten en la opción preferida para el aprendizaje profundo.

Sin embargo, básicamente, las GPU son de uso general: aunque han impulsado con éxito la revolución de IA de esta década, sus diseños no están optimizados para esa tarea. Estas deficiencias limitan la velocidad a la que los chips pueden ejecutar los algoritmos de aprendizaje profundo y hacen que consuman enormes cantidades de energía en el proceso.

Como respuesta, las compañías han competido por diseñar nuevas estructuras de chips especialmente adecuadas para la IA. Si están bien diseñados, esos chips tienen el potencial de entrenar modelos de aprendizaje profundo hasta 1.000 veces más rápido que las GPU y consumiendo mucha menos energía. Cerebras se encuentra entre la larga lista de empresas que desde entonces han aprovechado esa oportunidad. También participan en la carrera start-ups como Graphcore, SambaNova y Groq, además de compañías tradicionales como Intel y Nvidia.

Un nuevo chip de IA que tenga éxito tendrá que cumplir varios criterios, según Stevens. Como mínimo, debe ser 10 o 100 veces más rápido que los procesadores de uso general cuando se trabaja con los modelos de IA del laboratorio. Muchos de los chips especializados están optimizados para las aplicaciones comerciales de aprendizaje profundo, como la visión artificial y el lenguaje, pero podrían no funcionar tan bien cuando se trata de los tipos de datos comunes en la investigación científica. «Tenemos muchos conjuntos de datos de dimensiones superiores», explica Stevens. Estos conjuntos entrelazan enormes fuentes de datos dispares y son mucho más complejos de procesar que una foto bidimensional.

El chip también debe ser fiable y fácil de usar. «Tenemos a miles de personas dedicándose al aprendizaje profundo en laboratorio y no todos son programadores ninjas», destaca Stevens. «¿Podrían las personas utilizar el chip sin tener que pasar tiempo aprendiendo algo nuevo sobre programación?»

Hasta ahora, el ordenador de Cerebras ha cumplido con todo lo previsto. Gracias a su tamaño de chip (es más grande que un iPad y tiene 1,2 billones de transistores para hacer cálculos), no es necesario conectar procesadores más pequeños, lo que puede ralentizar el entrenamiento del modelo. En las pruebas, ha reducido el tiempo de entrenamiento de las modelos de semanas a horas. «Queremos poder entrenar estos modelos lo suficientemente rápido para que el científico que lleva a cabo el entrenamiento aún recuerde cuál era la pregunta cuando empezó», subraya Stevens.

Inicialmente, Argonne ha estado probando el ordenador en su investigación de fármacos contra el cáncer. El objetivo es desarrollar un modelo de aprendizaje profundo que pueda predecir cómo un tumor podría responder a un medicamento o a una combinación de medicamentos. El modelo se puede utilizar de dos maneras: para desarrollar nuevos candidatos a fármacos que podrían tener los efectos deseados en un tumor específico o para predecir los efectos de un único candidato a fármaco en muchos tipos diferentes de tumores.

Stevens espera que el sistema de Cerebras acelere drásticamente tanto el desarrollo como la implementación de un modelo de medicamento contra el cáncer, lo que podría suponer entrenar al modelo cientos de miles de veces y luego ejecutarlo miles de millones más para hacer predicciones sobre cada candidato a medicamento.

También espera que impulse la investigación de laboratorio en otros temas, como el desarrollo de materiales de baterías y las lesiones cerebrales traumáticas. El primer trabajo implicaría desarrollar un modelo de IA para predecir las propiedades de millones de combinaciones moleculares para encontrar alternativas a la química de iones de litio. El segundo supondría desarrollar un modelo para predecir las mejores opciones de tratamiento. Es una tarea extremadamente difícil porque requiere procesar muchos tipos de datos (imágenes cerebrales, biomarcadores, texto) muy rápido.

Stevens está entusiasmado con el potencial que la combinación de avances de software y hardware de inteligencia artificial conllevará a la exploración científica. «Va a cambiar la simulación científica de forma drástica», concluye.

Fuente: technologyreview.es