Un equipo de investigadores del MIT ha desarrollado una nueva técnica para entrenar robots multipropósito, capaz de mejorar significativamente su desempeño en tareas diversas. La técnica, conocida como Composición de Políticas (PoCo), combina múltiples fuentes de datos para crear un modelo de inteligencia artificial más eficiente y versátil.

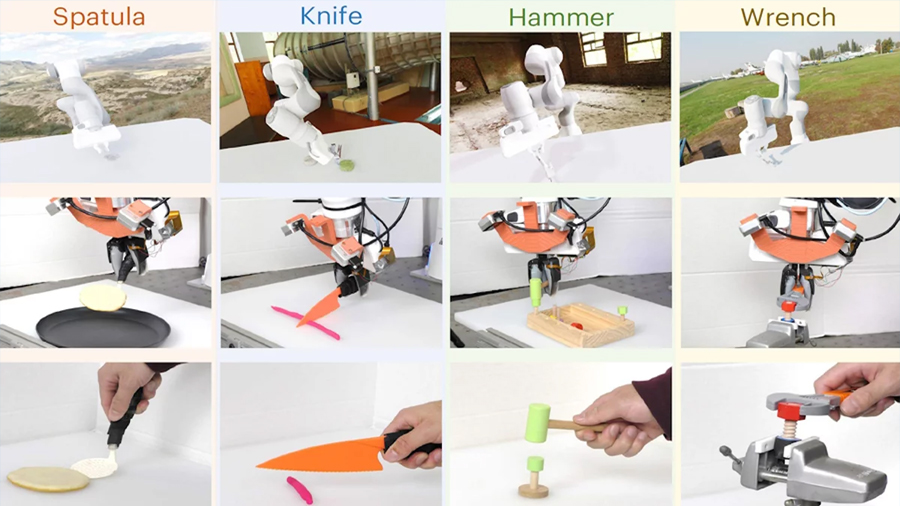

El entrenamiento de robots para realizar reparaciones en casa con herramientas como martillos, llaves y destornilladores requiere una enorme cantidad de datos que demuestren el uso de estas herramientas. Hasta ahora, los conjuntos de datos robóticos han variado ampliamente en modalidad y dominio, desde imágenes en color hasta huellas táctiles, y han sido recopilados en simulaciones o mediante demostraciones humanas.

La integración eficiente de datos de múltiples fuentes en un modelo de aprendizaje automático es compleja. La mayoría de los métodos actuales utilizan solo un tipo de datos para entrenar a los robots, lo que limita su capacidad para realizar nuevas tareas en entornos desconocidos. Los investigadores del MIT han abordado este desafío desarrollando PoCo, que permite combinar datos de diferentes fuentes, modalidades y tareas utilizando modelos de difusión.

Entonces, el proceso comienza con el entrenamiento de modelos de difusión separados para aprender estrategias específicas de tareas a partir de conjuntos de datos individuales. Estas estrategias se combinan luego en una política general que permite a los robots realizar múltiples tareas en diversos entornos. En pruebas realizadas tanto en simulaciones como en experimentos del mundo real, PoCo ha demostrado una mejora del 20% en el desempeño de tareas en comparación con las técnicas de referencia.

«Abordar la heterogeneidad en los conjuntos de datos robóticos es como un problema del huevo de gallina. Si queremos utilizar una gran cantidad de datos para entrenar políticas generales de robots, primero necesitamos robots desplegables para obtener todos estos datos», explica Lirui Wang, estudiante de posgrado en ingeniería eléctrica e informática y autor principal del estudio. La investigación se presentará en la Conferencia Robótica: Ciencia y Sistemas.

Una política robótica es un modelo de aprendizaje automático que toma entradas y las utiliza para realizar una acción. Los investigadores del MIT han desarrollado una técnica que puede tomar una serie de conjuntos de datos más pequeños, aprender políticas separadas de cada uno y combinarlas de manera efectiva. Representan cada política utilizando modelos de difusión, que aprenden a generar trayectorias refinando iterativamente su salida.

Según Wang, «Uno de los beneficios de este enfoque es que podemos combinar políticas para obtener lo mejor de ambos mundos. Por ejemplo, una política formada con datos del mundo real podría lograr una mayor destreza, mientras que una política formada con simulación podría lograr una mayor generalización». Esta capacidad de mezclar y combinar políticas de difusión mejora los resultados y permite la adaptación a nuevas tareas.

Los investigadores probaron PoCo en simulaciones y con brazos robóticos reales realizando diversas tareas, como usar un martillo y voltear objetos con una espátula. PoCo condujo a una mejora del 20% en el desempeño de tareas. En el futuro, los investigadores quieren aplicar esta técnica a tareas más complejas y a incorporar conjuntos de datos robóticos más grandes para mejorar aún más el rendimiento.

Fuente: notipress.mx