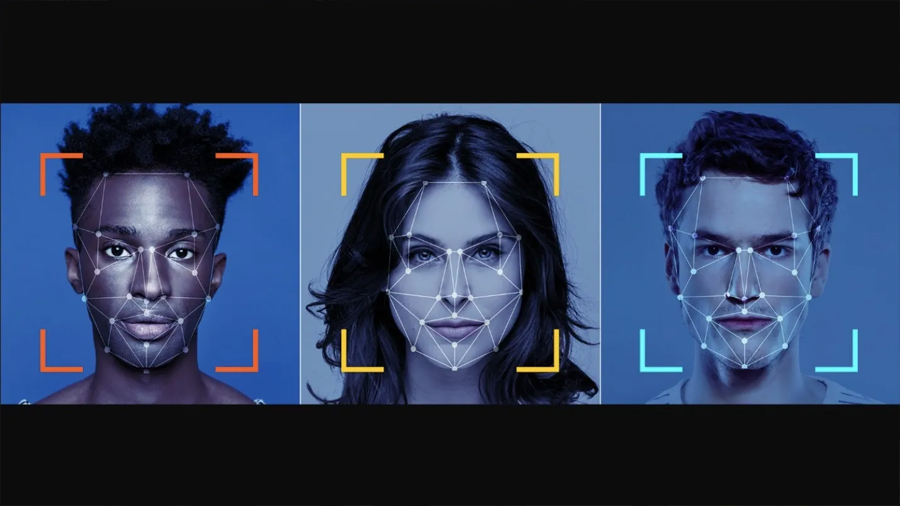

Microsoft está retirando su soporte para algunas funciones impulsadas por IA, incluido el reconocimiento facial

Microsoft se está alejando de su apoyo público a algunas funciones impulsadas por IA, incluido el reconocimiento facial, y reconoce los problemas de discriminación y precisión que crean estas ofertas. Pero la empresa tuvo años para solucionar los problemas y no lo hizo. Eso es similar a un fabricante de automóviles que retira un vehículo en lugar de repararlo.

A pesar de las preocupaciones de que la tecnología de reconocimiento facial pueda ser discriminatoria, el verdadero problema es que los resultados son inexactos. (Sin embargo, el argumento discriminatorio juega un papel debido a las suposiciones que hicieron los desarrolladores de Microsoft al crear estas aplicaciones).

Comencemos con lo que hizo y dijo Microsoft. Sarah Bird, la principal gerente de productos del grupo para Azure AI de Microsoft, resumió el retroceso el mes pasado en un blog de Microsoft.

“A partir de hoy (21 de junio), los nuevos clientes deben solicitar acceso para usar operaciones de reconocimiento facial en Azure Face API, Computer Vision y Video Indexer».

«Los clientes existentes tienen un año para solicitar y recibir aprobación para el acceso continuo a los servicios de reconocimiento facial en función de los casos de uso proporcionados».

«Al presentar el acceso limitado, agregamos una capa adicional de escrutinio al uso y la implementación del reconocimiento facial para garantizar que el uso de estos servicios se alinee con el estándar de inteligencia artificial responsable de Microsoft y contribuya a un beneficio social y de alto valor para el usuario final».

«Esto incluye la introducción de casos de uso y requisitos de elegibilidad del cliente para obtener acceso a estos servicios».

«Las capacidades de detección facial, incluida la detección de desenfoque, exposición, anteojos, posición de la cabeza, puntos de referencia, ruido, oclusión y cuadro delimitador facial, seguirán estando disponibles en general y no requieren una aplicación».

Mire esa segunda oración, donde Bird destaca este aro adicional para que los usuarios salten «para garantizar que el uso de estos servicios se alinee con el estándar de inteligencia artificial responsable de Microsoft y contribuya a un beneficio social y de alto valor para el usuario final».

Esto ciertamente suena bien, pero ¿es eso realmente lo que hace este cambio? ¿O Microsoft simplemente se apoyará en él como una forma de evitar que las personas usen la aplicación donde las imprecisiones son mayores?

Microsoft habla sobre racismo en el reconocimiento de voz

Una de las situaciones que discutió Microsoft involucra el reconocimiento de voz, donde descubrió que «la tecnología de voz a texto en todo el sector tecnológico producía tasas de error para los miembros de algunas comunidades negras y afroamericanas que eran casi el doble que para los usuarios blancos», dijo Natasha Crampton, director responsable de inteligencia artificial.

“Dimos un paso atrás, consideramos los hallazgos del estudio y descubrimos que nuestras pruebas previas al lanzamiento no habían tenido en cuenta satisfactoriamente la rica diversidad del habla entre personas con diferentes antecedentes y de diferentes regiones”.

Otro problema que identificó Microsoft es que las personas de todos los orígenes tienden a hablar de manera diferente en entornos formales e informales. ¿En serio? ¿Los desarrolladores no sabían eso antes? Apuesto a que lo hicieron, pero no pensaron en las implicaciones de no hacer nada.

Una forma de abordar esto es reexaminar el proceso de recopilación de datos. Por su propia naturaleza, las personas que se graban para el análisis de voz estarán un poco nerviosas y es probable que hablen de manera estricta y rígida.

Una forma de lidiar con esto es realizar sesiones de grabación mucho más largas en un ambiente lo más relajado posible. Después de unas horas, algunas personas pueden olvidar que están siendo grabadas y adoptar patrones de conversación informales.

He visto cómo la gente interactúa con el reconocimiento de voz. Al principio, hablan despacio y tienden a pronunciar demasiado. Con el tiempo, caen lentamente en lo que llamaré modo «Star Trek» y hablan como lo harían con otra persona.

Se descubrió un problema similar con los esfuerzos de detección de emociones.

Más de Bird: “En otro cambio, retiraremos las capacidades de análisis facial que pretenden inferir estados emocionales y atributos de identidad como género, edad, sonrisa, vello facial, cabello y maquillaje.

Colaboramos con investigadores internos y externos para comprender las limitaciones y los beneficios potenciales de esta tecnología y navegar por las ventajas y desventajas.

Específicamente en el caso de la clasificación de emociones, estos esfuerzos plantearon preguntas importantes sobre la privacidad, la falta de consenso sobre una definición de emociones y la incapacidad de generalizar el vínculo entre la expresión facial y el estado emocional en casos de uso, regiones y demografía.

El acceso de la API a las capacidades que predicen los atributos confidenciales también abre una amplia gama de formas en las que se pueden utilizar indebidamente, incluido someter a las personas a estereotipos, discriminación o denegación injusta de servicios.

Para mitigar estos riesgos, hemos optado por no admitir un sistema de propósito general en Face API que pretenda inferir estados emocionales, género, edad, sonrisa, vello facial, cabello y maquillaje.

La detección de estos atributos ya no estará disponible para los nuevos clientes a partir del 21 de junio de 2022, y los clientes existentes tienen hasta el 30 de junio de 2023 para interrumpir el uso de estos atributos antes de que se retiren”.

En la detección de emociones, históricamente se ha demostrado que el análisis facial es mucho menos preciso que el simple análisis de voz.

El reconocimiento de voz de la emoción ha demostrado ser bastante efectivo en aplicaciones de centros de llamadas, donde un cliente que suena muy enojado puede ser transferido de inmediato a un supervisor senior.

Hasta cierto punto, eso ayuda a demostrar el punto de Microsoft de que es la forma en que se usan los datos lo que debe restringirse.

En ese escenario del centro de llamadas, si el software es incorrecto y el cliente no estaba realmente enojado, no se hace daño.

El supervisor simplemente completa la llamada normalmente. Nota: la única detección común de emociones con voz que he visto es cuando el cliente está enojado con el árbol de teléfonos y su incapacidad para comprender oraciones simples.

El software cree que el cliente está enojado con la empresa. Un error razonable.

Pero, de nuevo, si el software está mal, no se hace daño.

Bird señaló que algunos casos de uso aún pueden confiar en estas funciones de IA de manera responsable.

“Los clientes de Azure Cognitive Services ahora pueden aprovechar el paquete Fairlearn de código abierto y el Fairness Dashboard de Microsoft para medir la equidad de los algoritmos de verificación facial de Microsoft en sus propios datos, lo que les permite identificar y abordar posibles problemas de equidad que podrían afectar a diferentes grupos demográficos antes”.

Bird también dijo que los problemas técnicos jugaron un papel en algunas de las imprecisiones.

«Al trabajar con clientes que utilizan nuestro servicio Face, también nos dimos cuenta de que algunos errores que originalmente se atribuían a problemas de imparcialidad se debían a la mala calidad de imagen».

«Si la imagen que alguien envía es demasiado oscura o borrosa, es posible que el modelo no pueda igualarla correctamente. Reconocemos que esta mala calidad de imagen puede concentrarse injustamente entre los grupos demográficos».

¿Entre los grupos demográficos? ¿No son todos, dado que todos pertenecen a algún grupo demográfico? Eso suena como una forma tímida de decir que los no blancos pueden tener una pobre funcionalidad de coincidencia.

Esta es la razón por la cual el uso de estas herramientas por parte de las fuerzas del orden es tan problemático. Una pregunta clave que debe hacerse TI: ¿Cuáles son las consecuencias si el software es incorrecto? ¿El software es una de las 50 herramientas que se utilizan o se confía únicamente en él?

Microsoft dijo que está trabajando para solucionar ese problema con una nueva herramienta. “Es por eso que Microsoft ofrece a los clientes una nueva API de calidad de reconocimiento que señala problemas de iluminación, desenfoque, oclusiones o ángulo de la cabeza en imágenes enviadas para verificación facial”, dijo Bird.

“Microsoft también ofrece una aplicación de referencia que brinda sugerencias en tiempo real para ayudar a los usuarios a capturar imágenes de mayor calidad que tienen más probabilidades de producir resultados precisos”.

En una entrevista con el New York Times, Crampton señaló que otro problema era que «el llamado clasificador de género del sistema era binario ‘y eso no es consistente con nuestros valores’».

En resumen, dice que si bien el sistema no solo piensa en términos de hombres y mujeres, no podría etiquetar fácilmente a las personas que se identifican de otras maneras de género. En este caso, Microsoft simplemente optó por dejar de intentar adivinar el género, lo que probablemente sea la decisión correcta.

Fuente: laverdadnoticias.com