Un nuevo robot creado en la Universidad de Columbia es capaz de simular una imagen de sí mismo, un relevante paso en el desarrollo de máquinas autoconscientes, materia de ciencia-ficción hasta ahora.

Los seres humanos son únicos en su capacidad de imaginarse a sí mismos en escenarios futuros, como caminar por la playa en un día cálido y soleado; y también pueden aprender revisando experiencias pasadas y reflexionando sobre lo que salió bien o mal.

Mientras que los humanos y los animales adquieren y adaptan su imagen de sí mismos a lo largo de su vida, la mayoría de los robots aún aprenden utilizando simuladores y modelos proporcionados por humanos, o mediante pruebas y errores laboriosos que requieren mucho tiempo; de forma que los robots no han aprendido a simularse como lo hacen los humanos.

Aprende qué es, desde cero

Pero, investigadores de ‘Columbia Engineering’ han logrado un gran avance en robótica al crear un robot que aprende qué es, desde cero, sin ningún conocimiento previo de física, geometría o dinámica motora.

Inicialmente, el robot no sabe si es una araña, una serpiente, un brazo; no tiene ni idea de cuál es su forma. Después de un breve periodo de «balbuceo» y dentro de un día de computación intensiva, el robot crea una auto-simulación. De esta forma, el robot puede emplear este auto-simulador internamente para contemplar y adaptarse a diferentes situaciones, manejando nuevas tareas como detectar y reparar daños en su propio cuerpo, tal y como se detalla en un artículo publicado en ‘Science Robotics’.

Hacia robots independientes

Hasta la fecha, los robots han estado operando por un humano que modela explícitamente el robot. «Pero si queremos que los robots se vuelvan independientes, entonces necesitan aprender a simularse», afirma en un comunicado Hod Lipson, profesor de Ingeniería Mecánica y director del laboratorio de Máquinas Creativas, donde se realizó la investigación.

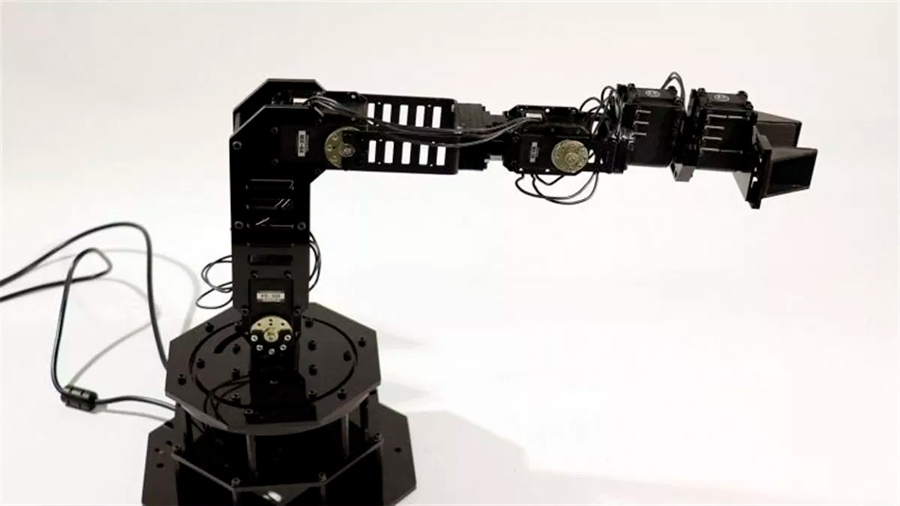

Para el estudio, Lipson y su estudiante de doctorado Robert Kwiatkowski usaron un brazo robótico articulado de cuatro grados de movimiento. Inicialmente, el robot se movió al azar y acumuló alrededor de mil trayectorias, cada una de las cuales comprendía cien puntos. Luego, el robot utilizó el aprendizaje profundo, una técnica moderna de aprendizaje automático, para crear un auto-modelo. Los primeros auto-modelos eran bastante inexactos, y el robot no sabía qué era ni cómo estaba conectado.

Pero después de menos de 35 horas de entrenamiento, el auto-modelo se volvió consistente con el robot físico hasta unos cuatro centímetros. El auto-modelo se realizó en un sistema de circuito cerrado que le permitió al robot recalibrar su posición original entre cada paso a lo largo de la trayectoria basándose completamente en el auto-modelo interno. Con el control de bucle cerrado, el robot pudo agarrar objetos en lugares específicos en el suelo y depositarlos en un receptáculo con un cien por cien de éxito.

Incluso en un sistema de bucle abierto, que implica realizar una tarea basada completamente en el modelo interno, sin ningún tipo de retroalimentación externa, el robot pudo completar la tarea de selección y colocación con una tasa de éxito del 44 por ciento. «Eso es como intentar recoger un vaso de agua con los ojos cerrados, un proceso difícil incluso para los humanos», observa el autor principal del estudio, Kwiatkowski, estudiante de doctorado en el Departamento de Informática que trabaja en el laboratorio de Lipson.

También se empleó el robot de auto-modelado para otras tareas, como escribir texto usando un marcador. Para probar si el auto-modelo podía detectarse daño a sí mismo, los investigadores imprimieron en 3D una parte deformada para simular el daño y el robot pudo detectar el cambio y volver a entrenar su auto-modelo. El nuevo auto-modelo permitió que el robot reanudara sus tareas de recoger y colocar con poca pérdida de rendimiento.

Lipson, quien también es miembro del Instituto de Ciencia de Datos, señala que la autoimagen es clave para permitir que los robots se alejen de los límites de la llamada «IA estrecha» hacia habilidades más generales. «Esto es quizás lo que hace un niño recién nacido en su cuna, a medida que aprende lo que es –dice–. Conjeturamos que esta ventaja puede haber sido el origen evolutivo de la autoconciencia en los humanos, mientras que creemos que es posible imaginar la autoconciencia».

Lipson cree que la robótica y la inteligencia artificial pueden ofrecer una nueva ventana al antiguo rompecabezas de la conciencia. «Los filósofos, psicólogos y científicos cognitivos han estado reflexionando sobre la naturaleza de la autoconciencia durante milenios, pero han progresado relativamente poco –observa–. Todavía ocultamos nuestra falta de comprensión con el tema del ‘lienzo de la realidad’, pero los robots ahora nos obligan a traducir estas nociones vagas en algoritmos concretos y mecanismos».

Lipson y Kwiatkowski son conscientes de las implicaciones éticas. «La autoconciencia llevará a sistemas más resistentes y adaptativos, pero también a cierta pérdida de control –advierten–. Es una tecnología poderosa, pero debe manejarse con cuidado». Los investigadores ahora están explorando si los robots pueden modelar no solo sus propios cuerpos, sino también sus propias mentes, si los robots pueden pensar en pensar.

Fuente: EP