En 2013, un grupo de agentes de la inteligencia británica notó algo extraño. La mayoría de los esfuerzos para asegurar la infraestructura digital se centraba en impedir que las incursiones de los hackers, pero había muy pocos proyectos dedicados a evitar que se filtrara la información. Sobre la base de esa idea, el grupo fundó una nueva empresa de ciberseguridad llamada Darktrace.

La compañía se asoció con matemáticos de la Universidad de Cambridge (Reino Unido) para desarrollar una herramienta de aprendizaje automático que detectara filtraciones internas. Pero, en vez de entrenar los algoritmos con los ejemplos históricos de los ataques, necesitaban una estrategia para que el sistema reconociera nuevos casos de comportamiento anómalo. Así que se centraron el aprendizaje no supervisado, una técnica basada en un extraño tipo de algoritmo de aprendizaje automático que no requiere que los humanos especifiquen qué es lo que habría que buscar.

«Es muy parecido al propio sistema inmunológico del cuerpo humano. A pesar de ser algo tan complejo, tiene un sentido innato de lo que es lo propio (el yo) y lo que es ajeno (el no-yo). Y cuando encuentra algo que no es propio, el no-yo, tiene una respuesta extremadamente precisa y rápida» explica la coCEO de la compañía, Nicole Eagan. .

La gran mayoría de las aplicaciones de aprendizaje automático se basan en el aprendizaje supervisado. Esto implica alimentar a una máquina con cantidades masivas de datos cuidadosamente etiquetados para que aprenda a reconocer un patrón estrechamente definido. Digamos que queremos que nuestra máquina reconozca a los perros de la raza golden retriever. La alimentamos con cientos o miles de imágenes de estos perros y de otras que no lo son, explícitamente indicando cuáles son los que nos interesan. Finalmente, tendremos a una máquina bastante decente para detectar la raza golden retriever.

En ciberseguridad, el aprendizaje supervisado funciona bastante bien. Se entrena a una máquina sobre los diferentes tipos de amenazas que el sistema ha enfrentado antes, y la máquina las persigue implacablemente.

Pero hay dos problemas importantes. Por un lado, esto solo funciona con las amenazas conocidas; las amenazas desconocidas aún se cuelan por el radar. Por otro lado, los algoritmos de aprendizaje supervisado funcionan mejor con conjuntos de datos equilibrados; en otras palabras, con los que tienen una cantidad igual de ejemplos de lo que se está buscando y de lo que se puede ignorar. Los datos de ciberseguridad están muy desequilibrados: existen muy pocos ejemplos de comportamientos amenazadores enterrados en una cantidad abrumadora de comportamientos normales.

Afortunadamente, donde el aprendizaje supervisado falla, el aprendizaje no supervisado acierta. Este último puede ver cantidades masivas de datos sin etiquetar y encontrar las piezas que no siguen un patrón típico. Como resultado, puede descubrir amenazas que un sistema nunca había visto antes y solo necesita pocos puntos de datos anómalos para hacerlo.

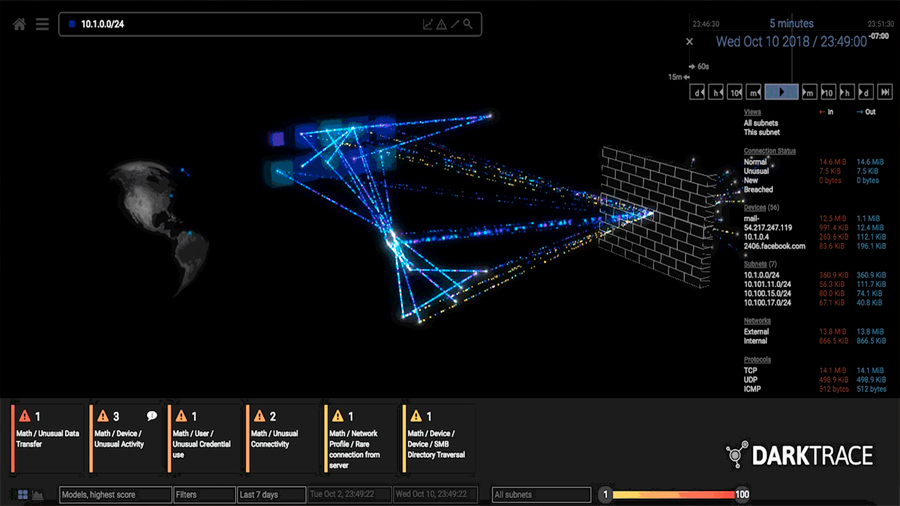

Cuando Darktrace implementa su software, configura sensores físicos y digitales alrededor de la red del cliente para trazar su actividad. Los datos sin procesar se canalizan a más de 60 diferentes algoritmos de aprendizaje no supervisado que compiten entre sí para encontrar un comportamiento anómalo.

Esos algoritmos luego pasan sus resultados a otro algoritmo superior que usa varios métodos estadísticos para determinar a cuáles de los 60 debe hacerles caso y a cuáles de ellos ignorar. Toda esa complejidad se empaqueta en una visualización final que permite a los operadores humanos ver posibles infracciones y responder rápidamente. Mientras los humanos deciden qué hacer a continuación, el sistema bloquea la infracción hasta que se resuelva, cortando, por ejemplo, toda la comunicación externa del dispositivo infectado.

Sin embargo, no es oro todo lo que reluce en el aprendizaje no supervisado. A medida que los hackers aumentan sus habilidades, mejoran su forma de engañar a las máquinas, independientemente del tipo de inteligencia artificial que se aplique. «Se produce un juego del gato y el ratón en el que los atacantes intentan cambiar su comportamiento», explica la experta en ciberseguridad y aprendizaje automático de la Universidad de California en Berkeley (EE.UU.) Dawn Song.En respuesta, la comunidad de ciberseguridad ha recurrido a enfoques proactivos: «mejores estructuras y principios de seguridad para que el sistema esté más seguro en su construcción», afirma. Pero todavía hay un largo camino para erradicar por completo todas las filtraciones y prácticas fraudulentas. Al fin y al cabo, agrega, «todo el sistema es tan seguro como su eslabón más débil».

La industria de lo no supervisado

Varias compañías también han optado por el aprendizaje no supervisado para mejorar los sistemas de seguridad digital.

Shape Security

Fundada en 2011 por exexpertos de Defensa del Pentágono, se centra en prevenir la creación de cuentas falsas y el fraude de aplicaciones de tarjetas de crédito, entre otras actividades maliciosas. Shape Security combina los puntos fuertes complementarios de las técnicas supervisadas y no supervisadas.

DataVisor

Fundada en 2013 por los exalumnos de Microsoft, se asocia con bancos, redes sociales y empresas de comercio electrónico para combatir el fraude de transacciones, el lavado de dinero y otros abusos a gran escala. DataVisor afirma que utiliza principalmente las técnicas no supervisadas.

Fuente: technologyreview.es