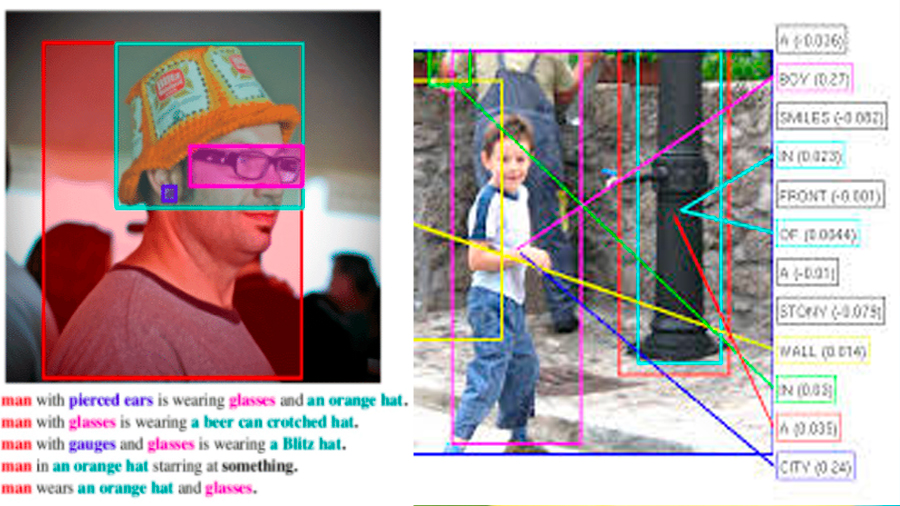

Han desarrollado un sistema que aprende a identificar objetos dentro de una imagen, basándose en una descripción hablada de ella. Ante una imagen con su comentario en audio, el modelo resaltará en tiempo real las regiones pertinentes que se han descrito.

A diferencia de las tecnologías actualmente disponibles de reconocimiento del habla, el sistema no precisa transcripciones manuales ni notas acerca de los ejemplos con los que haya sido adiestrado. En vez de eso, aprende palabras directamente a partir de fragmentos de habla registrados y objetos procedentes de imágenes en bruto, y los asocia entre sí.

Este notable desarrollo es obra del equipo de David Harwath, del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL), adscrito al Instituto Tecnológico de Massachusetts (MIT), en Cambridge, Estados Unidos.

El sistema puede actualmente reconocer solo varios cientos de palabras y tipos de objetos diferentes. Pero los investigadores esperan que un día su técnica de reconocimiento combinado de expresiones habladas y objetos en imágenes pueda ahorrar incontables horas de trabajo manual y abrir nuevas puertas en este tipo de reconocimiento.

Sistemas de reconocimiento del habla como Siri, por ejemplo, requieren transcripciones de muchos miles de horas de grabaciones de textos hablados. Usando estos datos, los sistemas aprenden a relacionar señales del habla con palabras específicas. Dicho método se hace especialmente problemático cuando, por ejemplo, entran nuevos términos en nuestro léxico, y los sistemas deben entonces volver a ser adiestrados.

Harwath y sus colaboradores querían realizar un reconocimiento del habla de una forma que fuera más natural, potenciando señales e información adicionales que los humanos usamos provechosamente, pero a las que los algoritmos de aprendizaje automático normalmente no tienen acceso. El equipo tuvo la idea de adiestrar un modelo de una forma similar a acompañar a un niño por el mundo y narrarle lo que vamos viendo.

Como ejemplo de la conducta del sistema, cabe citar su trabajo con una imagen de prueba en la que se muestra una chica joven con pelo rubio y ojos azules, llevando un vestido azul, y con un faro blanco con tejado rojo en segundo plano. El sistema aprendió a asociar qué píxeles en la imagen se correspondían con las palabras (en su versión inglesa) «chica», «pelo rubio», «ojos azules», «vestido azul», «faro blanco» y «tejado rojo». Cuando se emitió una descripción sonora, el sistema resaltó cada uno de esos objetos en la imagen a medida que se mencionaban.

Fuente: noticiasdelaciencia.com