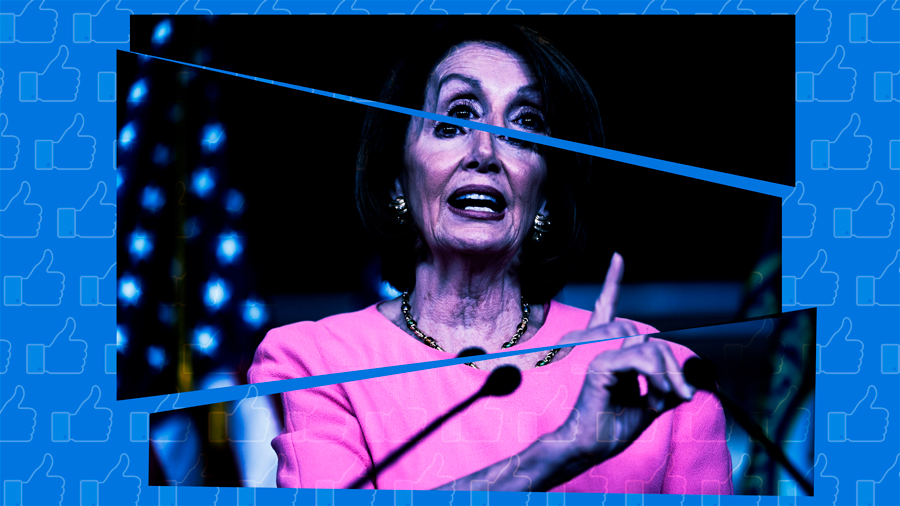

Hay mucha gente criticando a Facebook por su decisión de no retirar de su plataforma un vídeo manipulado de la presidenta de la Cámara de Representantes de EE.UU., Nancy Pelosi. El corte fue modificado a cámara lenta para que pareciera que estaba borracha. Pero algunos expertos defienden que eliminar el vídeo podría sentar un precedente aún más dañino.

Aunque el vídeo hace que Pelosi aparezca rara, no se trata de un deepfake, es decir, no la muestra diciendo algo que nunca dijo. Es un ejemplo de lo que el investigador del MIT Media Lab Hossein Derakhshan llama «mala información», o básicamente información cierta pero sutilmente manipulada para dañar a alguien.

Derakhshan cree sí se debería haber retirado el vídeo si este hubiera sido manipulado para mostrar a Pelosi haciendo un insulto racial, por ejemplo, pero considera que esperar que las redes sociales se dediquen a vigilar la mala información sería demasiado. El experto sostiene: «En general, cuando alguien hace estas manipulaciones, no creo que sea ilegal. Por lo tanto, no hay motivo para eliminarlos o solicitar que se retiren».

Es fácil imaginar que se impusiera una regla como la de «Eliminar vídeos falsos de discursos de odio», pero es mucho más difícil definir una norma que requiera eliminar el vídeo de Pelosi sin afectar a otras formas de burla, sátira o discrepancia.

La burla política, al fin y al cabo, suele usar información fuera de contexto y tiene la intención de hacer daño. Una norma demasiado amplia podría resultar contraproducente en países autoritarios, según el miembro de TED que estudia la desinformación Alexios Mantzarlis, y quien ya ha trabajado para crear las asociaciones de Facebook con agencias de verificación.

El joven afirma: «Mi opinión es que esto no parece causar daño a alguien en la vida real, y que, si empezamos a eliminar las cosas, el precedente podría resultar problemático, especialmente [para] los políticos». No es difícil imaginar la presión a la que se podría someter a Facebook para eliminar un vídeo satírico contra alguien como Jair Bolsonaro o Donald Trump.

Eso no significa que ningún vídeo deba ser borrado (Mantzarlis destaca que no es un absolutista de la libertad de expresión), solo que hay matices cuando se trata de distintos tipos de manipulación, el potencial de daño y lo que las plataformas deberían hacer.

En cualquier caso, «dejarlo» o «quitarlo» no son las únicas opciones. Facebook etiquetó el vídeo con advertencias de organizaciones de verificación de datos, pero Mantzarlis tuiteó otras cuatro estrategias para que Facebook tomara medidas más efectivas.

Por ejemplo, el vídeo podía haber sido etiquetado mucho antes y de forma más visible. Ahora mismo, si se intenta compartir, solo aparece una pequeña y sutil advertencia sobre su autenticidad. Mantzarlis sugiere que Facebook también podría invitar a los usuarios que compartieron el vídeo a no hacerlo o poner no me gusta, y luego compartir los datos con los investigadores que intentan entender qué es lo que funciona para combatir la propagación de los medios manipulados.

«Este es el mayor experimento de la vida real en la lucha contra la desinformación digital en la historia y, por lo tanto, la riqueza del conocimiento que esto podría generar y proporcionar a los investigadores y a otros profesionales que luchan contra la desinformación sería realmente extraordinaria», añade.

Derakhshan coincide en que es importante etiquetar los vídeos que se han modificado de alguna manera, pero sugiere que la mejor solución es fomentar la alfabetización mediática. A medida que tratamos cada vez más con las imágenes, es importante enseñar a las personas a ser escépticas con los vídeos, de la misma manera que ahora es común preguntarse si una imagen ha pasado por Photoshop. «Todo el mundo debería pensar siempre en la posibilidad de que el vídeo que está viendo ha sido manipulado», concluye.

Fuente: technologyreview.es