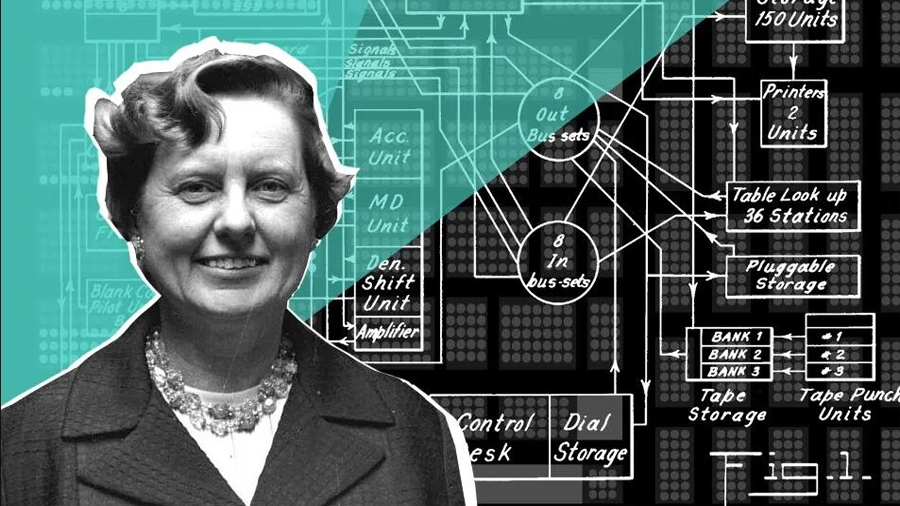

Centenario de Margaret Dayhoff: los orígenes de la bioinformática evolutiva, fue el nombre de la mesa que formó parte del ciclo Los viernes de la evolución, coordinado por los colegiados Antonio Lazcano y José Sarukhán

Margaret Dayhoff fue una de las grandes científicas del siglo XX, nació hace cien años y se formó como química cuántica. “Esta sesión no sólo es un homenaje a su memoria, sino un reconocimiento de lo que todos a nivel mundial tenemos con su visión de lo que significan las bases de datos”, comentó Antonio Lazcano, miembro de El Colegio Nacional, en la mesa Centenario de Margaret Dayhoff: los orígenes de la bioinformática evolutiva, como parte del ciclo Los viernes de la evolución.

El colegiado recordó que Dayhoff se formó como química cuántica, pero trabajó en la astronomía. A finales de los años cincuenta, se interesó por la estructura de la atmósfera de Júpiter y Venus, planetas de los que realizó modelos. “Era muy amiga de Carl Sagan, uno de los promotores de la astronomía, y se dio cuenta que los modelos que existían en esa época eran muy aburridos, por lo que comenzó a trabajar en la creación de una base de datos de utilidad para todo el mundo”.

“Fue la primera que se dio cuenta que podemos usar los llamados genes parálogos, es decir, genes que se duplicaron antes de que hubiera un fenómeno de especiación, para generar los grupos externos. En otras palabras, se puede utilizar una secuencia de un gen parálogo o un conjunto de secuencias parálogo para enraizar un árbol filogenético. Gracias a este descubrimiento y al formalismo matemático que ella introduce, ahora podemos darles polaridad a los árboles evolutivos y podemos saber cuál es la dirección en la que están evolucionando, por ejemplo, la resistencia antibiótica de una bacteria o las variantes de COVID-19”, detalló el biólogo mexicano.

Agregó que un tercer logro de la fisicoquímica estadounidense fue que ella se dio cuenta de las proteínas que crecen a partir de repeticiones, como las Ferrodoxinas, provienen de bacterias que alguna vez fueron organismos de vida libre. “Ella es un ejemplo excepcional que curiosamente no ha sido rescatada por el feminismo más radical, pero que es un ejemplo de cómo se puede combinar, una vida de madre, de ama de casa, de abuela con un trabajo científico de primer orden”.

Al tomar la palabra, Edna Suárez, de la Facultad de Ciencias de la UNAM, sostuvo que Margaret Dayhoff fue pionera en la introducción de métodos computacionales y matemáticos en problemas de bioquímica. “Produjo la primera colección de secuencias de proteínas basada en el uso de computadoras”.

Como parte de su vida, Dayhoff estudió el doctorado en Química Cuántica en la Universidad de Columbia. En 1947 comenzó a usar tarjetas perforadas para determinar energías de resonancia. En 1960 fue contratada por Ledley por la National Biomedical Research Foundation (NBRF), una fundación privada no lucrativa. En 1965 publicó la primera versión del Atlas of Protein Sequence and Structure con 65 secuencias, utilizando un código de una letra para los aminoácidos, y guardando la información en tarjetas perforadas.

En palabras de Suárez, la pionera del campo de la bioinformática desarrolló las primeras matrices de sustitución de aminoácidos, indispensables en el análisis de secuencias (PAMs). “La Historia Natural es la tradición más antigua de la biología, pero sigue vigente. El trabajo de Dayhoff enlazó la historia natural de las macromoléculas biológicas con la introducción de las computadoras en la biología”.

Detalló que la práctica de comparar secuencias inició en la década de 1950, tan pronto se contó con las primeras secuencias de aminoácidos-bioquímica de proteínas. “La National Borzoi Rescue Foundation fue fundada por Robert Ledley para desarrollar las aplicaciones de las computadoras electrónicas en la biomedicina. Entre 1962 y 1964, Dayhoff y Ledley desarrollan numerosos programas en FORTRAN para la nueva IBM 7090 de Georgetown University, que podía ensamblar secuencias cortas en cinco minutos”.

“Requería una revisión exhaustiva de la literatura científica. Contenía información adicional y corregía errores de las publicaciones. Medía las “relaciones evolutivas”. El Protein Data Bank y el GenBank fueron creados bajo los mismos principios sobre los que fue creado el Atlas. El trabajo de Dayhoff representa la síntesis de las prácticas de la historia natural, la biología molecular experimental y las nuevas tecnologías en la biología contemporánea”, concluyó Edna Suárez.

Por su parte, Carlos Coello, miembro de El Colegio Nacional, se refirió a la historia de las bases de datos computarizadas, que comenzaron en los sesenta, cuando el uso de las computadoras se volvió una opción viable en término de costo-efectividad para las organizaciones privadas. “En esa época, había dos modelos de datos que eran populares: un modelo de red desarrollado por un consorcio de empresas de tecnología llamado Conference on Data Systems Languages (CODASYL); un modelo jerárquico desarrollado por IBM, llamado Information Management System (IMS)”.

Aseguró que Edgar F. Codd, de IBM, publicó en 1970 un artículo que sirvió como introducción a las denominadas bases de datos relacionales. “Las ideas de Codd cambiaron para siempre la forma en la que se estudiaban las bases de datos, pues en su modelo, la organización de los datos es independiente del sistema de almacenamiento físico”.

Después, en los noventa, se liberaron nuevas herramientas para el desarrollo de aplicaciones, incluyendo Oracle Developer, Power Builder y VB, entre otras. El Internet llevó a un crecimiento exponencial de la industria de las bases de datos y popularizó el modelo cliente-servidor. Este modelo permite que varios usuarios compartan sus bases de datos y condenó a la obsolescencia a los costosos mainframes en los que se crearon los primeros sistemas de manejo de bases de datos, puntualizó el colegiado.

Sostuvo que “fue también, en esta época, que los usuarios de computadoras personales comenzaron a utilizar de forma cotidiana sistemas de bases de datos y el uso extendido de Internet motivó las ventas en línea, lo cual requirió modelos de bases de datos que permitieran transacciones seguras. En 1998, Carlo Strozzi acuñó el término “NoSQL” para referirse a un tipo diferente de bases de datos. Las bases de datos NoSQL se distinguen de las demás, porque emplean una estructura flexible, sin esquema definido”.

Las bases de datos NoSQL están diseñadas para manejar enormes volúmenes de datos no estructurados o semi-estructurados, tales como contenido de redes sociales, datos de sensores o multimedios. A diferencia de las bases de datos relacionales, las NoSQL usan varios modelos basados en documentos, para optimizar el desempeño y la escalabilidad, aseguró el ingeniero mexicano.

“Hoy en día, es común usar bases de datos distribuidas, es decir, con datos que residen en varios servidores, pero que se perciben como si estuvieran en un solo lugar, así como el manejo de enormes cantidades de datos. Áreas como la bioinformática y la física de partículas han generado nuevos desafíos por la enorme cantidad de información que generan”, concluyó Coello Colello.

Fuente: El Colegio Nacional