“Los programas de computadora no son herramientas pensadas para causar daño, sino para apoyarnos, y el elemento humano persiste detrás”, sostuvo Carlos Coello miembro electo de El Colegio Nacional

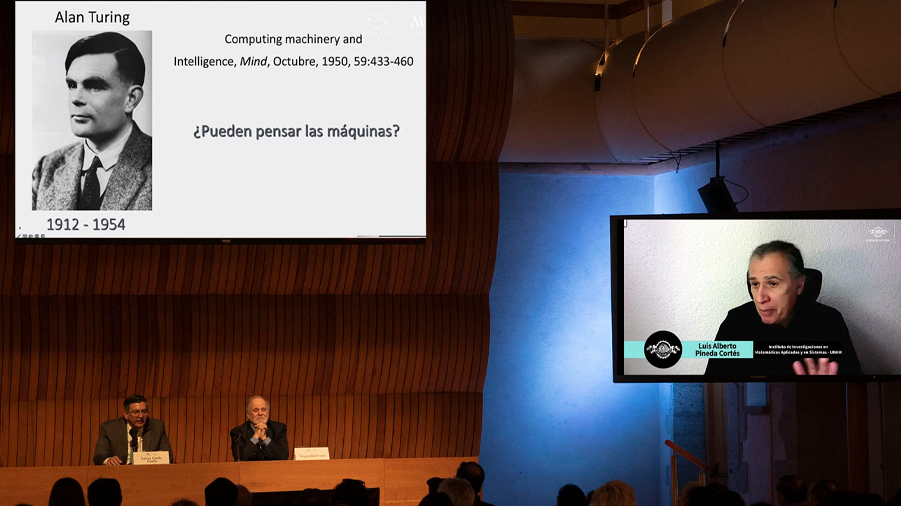

Desde el origen de la Inteligencia Artificial (IA) hasta lo que se espera de esta tecnología en el futuro, así como cuestiones éticas, protección de datos y la relación con los seres humanos, fueron algunos de los temas que se reflexionaron en la mesa ¿Las máquinas pueden pensar? ChatGPT y el aprendizaje de máquina, coordinada por Alejandro Frank, miembro de El Colegio Nacional.

En la sesión, transmitida en vivo el 30 de marzo por las plataformas digitales de la institución, participaron los científicos computacionales Carlos Coello Coello, del Cinvestav y miembro electo de El Colegio Nacional; Luis Alberto Pineda Cortés, de la UNAM; y el matemático Raúl Rojas, de la Universidad Libre de Berlín.

Al respecto del origen y la evolución de la inteligencia artificial, el especialista Carlos Coello Coello aseguró que se trata de un área de estudio dentro de las ciencias de la computación con un antecedente diverso, “el término se acuñó a raíz de un evento realizado por los científicos e informáticos John McCarthy, Marvin Minsky y Nathan Rochester en 1956, titulado Dartmouth Summer Research Project on Artificial Intelligence (Proyecto de Investigación de Verano de Dartmouth sobre Inteligencia Artificial) momento en el que surgió la IA como disciplina de estudio.

Agregó que, entre los primeros trabajos en torno a las máquinas pensantes, se encontró el del matemático inglés Alan Turing, quien creó la prueba operativa de inteligencia de una máquina para exhibir su comportamiento, considerada uno de los grandes hitos dentro de la IA. Recordó que, desde sus orígenes, la IA siempre buscó simular la inteligencia humana.

De acuerdo con el miembro electo de la institución, la inteligencia artificial de los años cincuenta fue conocida como simbólica, porque entrenaba de la misma manera en que el cerebro humano, aprendía y estaba basada en la lógica, pero la IA actual es subsimbólica, ya que la información se almacena en números y se basa en las redes neuronales. “No hay que perder de vista que estos programas de computadora no tienen un entendimiento ni una conciencia de lo que resuelven, porque operan a través de números. No son herramientas pensadas para causar daño sino para apoyarnos, y el elemento humano persiste detrás”, puntualizó el investigador.

Por su parte, el especialista en computación y mecatrónica Raúl Rojas se refirió a la IA subsimbólica. Detalló que las neuronas son lentas, una serie de entes individuales que utilizan electricidad para comunicarse. “Sabemos que tienen conductos de entrada de datos, tienen cuerpo para acumulación de estos datos y transmisión hacia el exterior”. En otras palabras, las neuronas están conectadas en redes de procesamiento de datos y son como mini procesadores.

Agregó que las redes neuronales artificiales llamadas modernas, tienen una estructura similar a las neuronas de los seres humanos, y cuentan con una entrada de datos, conductos de transmisión y una unidad de salida. “Lo más importante es que estas redes no son programadas, aprenden a comportarse de cierta manera. Y han crecido tanto que se les conoce como redes de aprendizaje profundo, porque hay cientos de datos de donde obtienen su información”.

De igual forma, expuso que en la tecnología de ChatGPT, se utilizan lo que se conoce como transformadores, una forma particular de conectar las redes neuronales profundas conectadas entre capas, es decir, entre las diferentes proyecciones matemáticas que se tienen en la información. “La técnica ha avanzado con la idea original de replicar las neuronas cerebrales con elementos electrónicos sencillos, en cuanto a elementos individuales, pero muy peligrosos cuando se conectan a una red de millones de millones de parámetros”.

De acuerdo con el experto, la inteligencia artificial siempre va a ser fundamentalmente diferente a la humana, porque “los humanos tienen un concepto del yo y tienen miedo a morir, la filosofía de explicar la razón de su existencia, algo que la computadora no se puede plantear. La inteligencia humana es un producto de la evolución biológica y como tal no es reproducible a las computadoras que tenemos hoy, que no le temen a nada”.

Al tomar la palabra, el científico computacional Luis Alberto Pineda Cortés, de la UNAM, sostuvo que las máquinas no pueden sentir. Una tecnología como ChatGPT es modelada por el lenguaje automático, pero se modela con una habilidad flotante, porque, por un lado, “no está conectado ni con el pensamiento, ni con la memoria y; por el otro, tampoco está aterrizado en el mundo”.

Después de realizar diversos ejercicios con esta aplicación, Pineda Cortés concluyó que ChatGPT se traba y se contradice, y esta es una señal de que no piensa. “Realmente repite como perico, de una manera sofisticada”. Subrayó las palabras de Alan Turing de dotar a la máquina con los mejores órganos sensoriales que el dinero pueda comprar para enseñarle a entender. Es decir, “hay que dotar a la máquina de lenguaje para que pueda aprenderlo como los seres humanos. Este proceso es aterrizado, como la adquisición del lenguaje de los niños y ese es el reto que tiene actualmente la inteligencia artificial. ChatGPT no lo hace”.

El investigador del Instituto de Investigaciones en Matemáticas Aplicadas y en Sistemas de la UNAM explicó que el lenguaje es una maquinaria interpretativa e intencional, es una metáfora que ha guiado a la inteligencia artificial. “Sin embargo, también es una habilidad que se entrena, se utiliza en automático y sin pensar”. Detalló que “el gran problema fuerte de la conciencia es que todavía no sabemos cómo resolver ¿por qué la materia física puede dar lugar a contenidos mentales? No podemos crear máquinas que lo resuelvan”.

El colegiado Alejandro Frank, sostuvo que “no existe razón para que las máquinas no puedan llegar a entender”, a sentir, evolucionar y tener verdadero sentido del humor. “Los humanos somos máquinas biológicas después de todo y hemos evolucionado por miles de millones de años, pero si nosotros llegamos a entender, no me queda claro ¿por qué las máquinas no podrían llegar a hacerlo?”.

Recordó las palabras del escritor e historiador israelí Yuval Noah Harari, en su libro Sapiens, en el que plantea que es muy difícil que la especie humana sobreviva y que, tal vez, las máquinas serán sus descendientes capaces de sobrevivir a los cambios del clima. “Le temo a la humanidad, no a las máquinas, la conciencia no es binaria, no es cero o uno, es un continuo, pienso que en el futuro podría surgir otro tipo de inteligencia”, puntualizó el colegiado.

En relación con la ética, Carlos Coello Coello aseguró que actualmente existe una nueva disposición en las revistas de tecnología que obliga a los autores a que subrayen toda la información que se hizo por ChatGPT. “Otro tema es el de la privacidad. Tenemos que entender que estas tecnologías están muy asociadas a la pérdida de privacidad y la información que utilizan tienen que ver con una invasión a ésta dentro de nuestra vida privada, lo cual tendría que estar regulado. “Hay que tener conciencia como humanos de ¿hasta dónde queremos que se desarrollen estos programas? Lo que hacemos es un llamado para regularlos”.

Para Raúl Rojas, el sistema automático computarizado no debe realizar una elección que implica una cuestión de ética, siempre debe haber un humano que toma ese tipo de decisiones. “La cuestión ética es muy discutida. Definir todas las áreas en las que un humano debe ser en última instancia responsable es tarea de la legislación, ahí estamos muy atrasados”.

Por su parte, Pineda Cortés expuso que las máquinas no tienen contenidos mentales y no tienen intencionalidad, “ellas simulan cosas y como tal no pueden estar sujetas a juicios éticos, porque no tienen libertad. Nosotros aportamos la intencionalidad al fenómeno computacional”.

En el tema del empleo, el científico Raúl Rojas comentó que sí debe existir una preocupación social por el hecho de que este proceso de transformación tecnológica va tan rápido, que efectivamente puede desplazar a muchos trabajadores. Expuso que los sindicatos en Alemania tienen una demanda en la que piden la semana laboral de cinco días, cuatro para trabajar en la empresa y el quinto lo utilizan para recapacitar a los trabajadores en tomar un nuevo empleo en caso de que sean desplazados. “A la pregunta de ¿las máquinas van a desplazar a los humanos? hay que decir sí, eso es muy distinto a que van a dominarnos”, finalizó el experto.

Fuente: El Colegio Nacional