Los ingenieros de Google aprendieron a crear un modelo realista de una persona en movimiento e incrustarlo en un espacio virtual, cambiando la iluminación del modelo. Crearon un stand con varias docenas de cámaras y cientos de fuentes de iluminación controladas, dentro de las cuales había una persona. El desarrollo se presentará en la conferencia SIGGRAPH Asia 2019, y un artículo al respecto ha sido publicado en el sitio web de los autores.

Contexto

Las tecnologías para capturar movimiento y crear avatares virtuales se han utilizado en varios campos durante muchos años. Algunos de ellos se basan en la captura de los movimientos de la cara y otras partes del cuerpo, cuyas grabaciones se utilizan para animar a otro personaje. En los casos en que es importante mantener la apariencia de una persona, se utilizan sistemas de múltiples cámaras.

Algunos desarrolladores en esta área han logrado obtener resultados de bastante alta calidad. Por ejemplo, Intel usa un sistema en algunos estadios deportivos que le permite mostrar repeticiones desde cualquier ángulo. Sin embargo, dichos sistemas no pueden recopilar datos sobre las propiedades ópticas de los objetos, y el modelo obtenido con su ayuda no puede transferirse de manera realista a un entorno con otra iluminación.

La novedad de Google

Un grupo de ingenieros de Google, dirigido por Paul Debevec y Shahram Izadi, creó un stand y un software que le permite crear un modelo que refleje de manera realista tanto la forma como las propiedades ópticas de una persona en movimiento, así como transferir este modelo a otro entorno y ajustar la iluminación para adaptarse a él.

El stand tiene un diseño casi esférico con una abertura a través de la cual entra una persona. En los bastidores que componen la esfera, se instalan 331 unidades de iluminación, cada una de las cuales consta de LED individuales de cierto color, 42 cámaras en color, así como 16 unidades de captura de profundidad, cada una de las cuales consta de un color y dos cámaras infrarrojas y un proyector láser infrarrojo. Dado que el sistema crea una gran cantidad de datos, su procesamiento se realiza en servidores en la nube.

Durante la operación, el láser proyecta un patrón infrarrojo que consiste en líneas finas. Gracias a esto, el sistema puede restaurar la forma de una persona con alta precisión al comparar los datos infrarrojos recibidos con el patrón original.

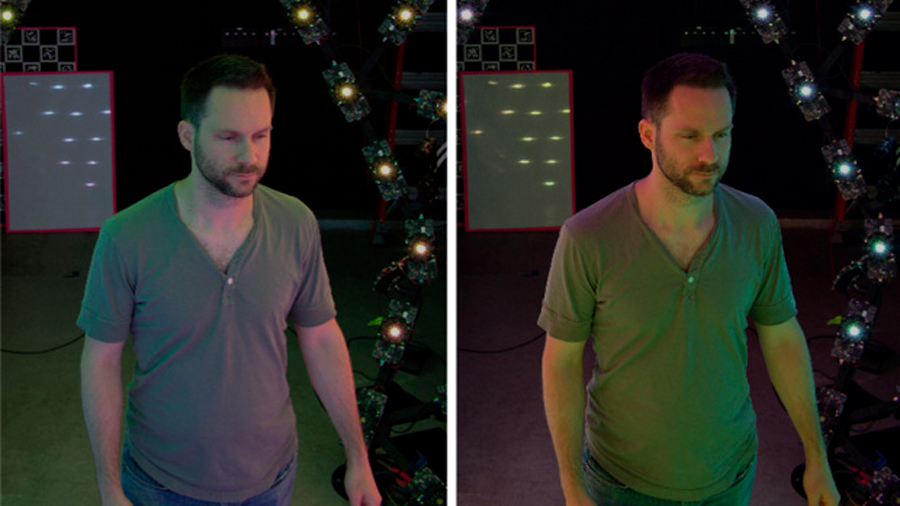

Los LED proyectan luz con la distribución espacial deseada, y rápidamente (60 veces por segundo) alternan dos gradientes de color opuestos entre sí. Esto le permite crear no solo un mapa de la distribución del color en el cuerpo y la ropa, sino también un mapa de reflexión, que le permite cambiar programáticamente la iluminación de una persona, integrándolo de manera realista en un nuevo entorno.

También una app

Los autores compararon su desarrollo con sistemas similares anteriores. El nuevo sistema le permite obtener un modelo con una resolución más alta, así como menos artefactos. Además, funciona mucho mejor con objetos que se mueven rápidamente, como una pelota lanzada.

Los desarrolladores también crearon una app de demostración que funciona en modo de realidad aumentada e integra de manera realista el modelo de una persona y lo muestra al frente del teléfono. Funciona sobre la base de un desarrollo anterior, que determina las características de iluminación y reflexión de los objetos de acuerdo con los datos de la cámara.

A principios de este año, el grupo de Paul Devebeck presentó otro desarrollo de hardware y software que permite efectos visuales inusuales. Armaron una cámara prototipo de campo de luz a partir de 16 GoPro, y utilizaron algoritmos para dividir la escena en planos separados, ordenados a medida que se alejaban de la cámara.

Fuente. nmas1.org