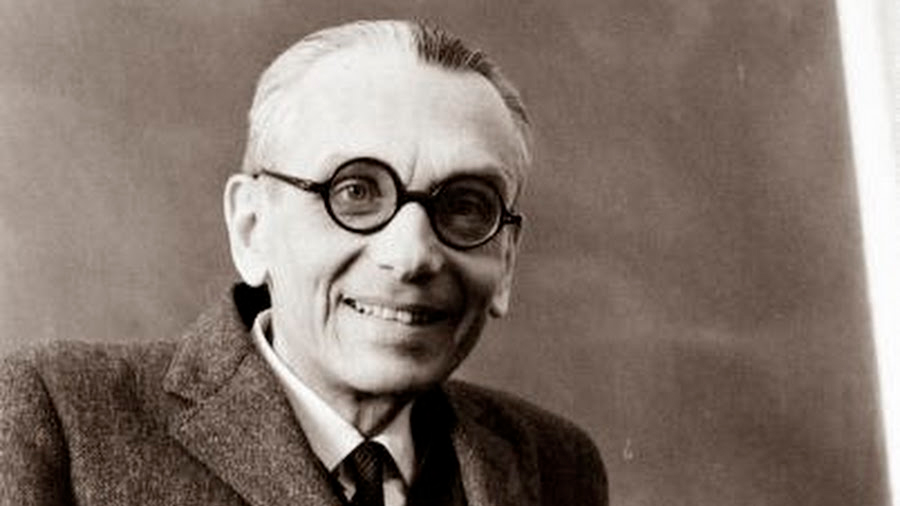

Un sencillo problema de Inteligencia Artificial se ha topado con una pregunta sin respuesta matemática, porque está vinculada a las paradojas lógicas de hace 80 años del matemático Kurt Gödel.

Matemáticos que estaban trabajando en un problema de aprendizaje automático llegaron a la conclusión de que la cuestión de la «capacidad de aprendizaje», si un algoritmo puede extraer un patrón de datos limitados, está vinculada a una paradoja conocida como la hipótesis del continuo.

Gödel, de origen austríaco, demostró que la afirmación no puede probarse como verdadera o falsa utilizando un lenguaje matemático estándar. El último resultado sobre la cuestión apareció ha sido publicado en Nature Machine Intelligence.

«Para nosotros, fue una sorpresa», dice –citado por Nature– Amir Yehudayoff en el Instituto de Tecnología Technion-Israel en Haifa, quien es coautor del artículo. Él dice que aunque hay una serie de preguntas técnicas de matemáticas que se sabe que son igualmente «indecidibles», no esperaba que este fenómeno apareciera en un problema relativamente simple en el aprendizaje automático.

Los investigadores a menudo definen la capacidad de aprendizaje en términos de si un algoritmo puede generalizar su conocimiento. El algoritmo recibe la respuesta a una pregunta de «sí o no», como «¿esta imagen muestra un gato?» para un número limitado de objetos, y luego tiene que adivinar la respuesta para los nuevos objetos.

Yehudayoff y sus colaboradores llegaron a su resultado mientras investigaban la conexión entre capacidad de aprendizaje y «compresión», lo que implica encontrar una manera de resumir las características principales de un gran conjunto de datos en un conjunto más pequeño de datos. Los autores descubrieron que la capacidad de la información para comprimirse de manera eficiente se reduce a una cuestión en la teoría de conjuntos: colecciones matemáticas de objetos, como los conjuntos en los diagramas de Venn. En particular, se relaciona con los diferentes tamaños de conjuntos que contienen infinitos objetos.

Georg Cantor, el fundador de la teoría de conjuntos, demostró en la década de 1870 que no todos los conjuntos infinitos son creados iguales: en particular, el conjunto de números enteros es «más pequeño» que el conjunto de todos los números reales, también conocido como el continuo. (Los números reales incluyen los números irracionales, así como los racionales y los enteros). Cantor también sugirió que no puede haber conjuntos de tamaño intermedio, es decir, más grandes que los enteros pero más pequeños que el continuo. Pero no pudo probar esta hipótesis de continuidad, y tampoco lo hicieron muchos matemáticos y lógicos que lo siguieron.

Sus esfuerzos fueron en vano. Un resultado de 1940 de Gödel (que fue completado en la década de 1960 por el matemático estadounidense Paul Cohen) mostró que la hipótesis del continuo no se puede probar ni verdadera ni falsa a partir de los axiomas estándar (las afirmaciones que se consideran verdaderas) de la teoría de conjuntos, que se toman comúnmente como la base de todas las matemáticas.

El trabajo de Gödel y Cohen sobre la hipótesis del continuo implica que pueden existir universos matemáticos paralelos que sean compatibles con la matemática estándar, uno en el que la hipótesis del continuo se agrega a los axiomas estándar y, por lo tanto, se declara verdadero y otro en el que se declara falso.

En su reciente artículo, Yehudayoff y sus colaboradores definen la capacidad de aprendizaje como la capacidad de hacer predicciones sobre un gran conjunto de datos mediante el muestreo de un pequeño número de puntos de datos.

El vínculo con el problema de Cantor es que hay infinitas formas de elegir el conjunto más pequeño, pero se desconoce el tamaño de ese infinito.

Los autores continúan demostrando que si la hipótesis del continuo es cierta, una pequeña muestra es suficiente para realizar la extrapolación. Pero si es falso, ninguna muestra finita puede ser suficiente. De esta manera, muestran que el problema de la capacidad de aprendizaje es equivalente a la hipótesis del continuo. Por lo tanto, el problema de la capacidad de aprendizaje también se encuentra en un estado de limbo que solo se puede resolver eligiendo el universo axiomático.

El resultado también ayuda a proporcionar una comprensión más amplia de la capacidad de aprendizaje, dice Yehudayoff. «Esta conexión entre la compresión y la generalización es realmente fundamental si quieres entender el aprendizaje».

Fuente: europapress.es