Las máquinas tampoco saben juzgar un libro por su portada, de momento

La expresión “nunca juzgues un libro por su portada” desaconseja evaluar algo únicamente por su aspecto. Pero aun así, las portadas de los libros están diseñadas para dar a los lectores una idea de su contenido, para hacer que quieran leérselo. Las buenas portadas están diseñadas para ser juzgadas. Eso es algo que los humanos esto se nos da muy bien. Resulta relativamente sencillo identificar un libro de recetas, una biografía o una guía de viajes sólo al mirar la portada. Pero, ¿las máquinas también pueden juzgar los libros por sus portadas?

Hoy recibimos algunas pistas gracias al trabajo de los investigadores de la Universidad Kyushu (Japón) Brian Kenji Iwana y Seiichi Uchida. Ambos han entrenado una red neuronal profunda para estudiar portadas de libros y determinar a qué categoría corresponden.

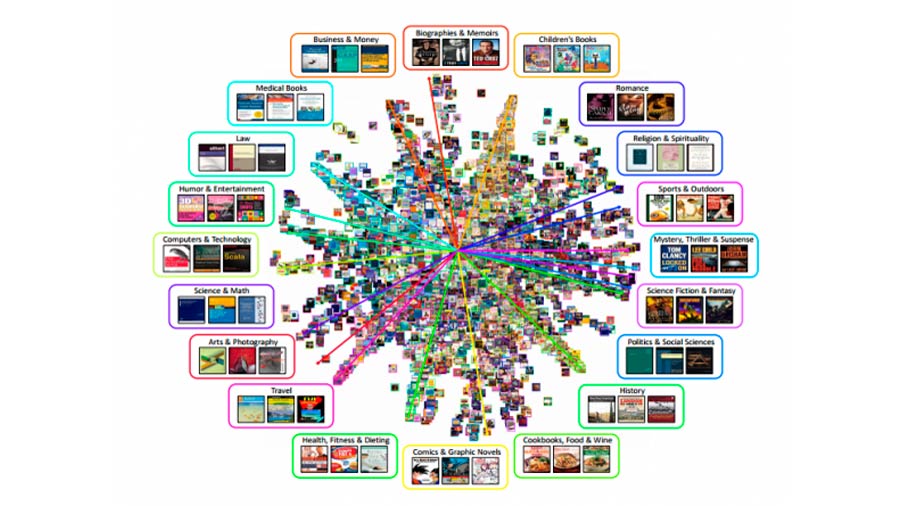

Su método es sencillo. Iwana y Uchida descargaron 137 mil 788 portadas de libro de Amazon.com junto a sus respectivos géneros. Hay 20 posibles categorías, pero cuando un libro tenía más de una, los investigadores sólo utilizaron la primera.

Después, emplearon el 80 por ciento del conjunto de datos para entrenar una red neuronal para reconocer el género al observar la imagen de portada. Su red neuronal tiene cuatro capas, cada una con hasta 512 neuronas. Todas ellas se combinan para aprender a reconocer la correlación entre el diseño de portada y el género. Emplearon otro 10 por ciento del conjunto de datos para validar el modelo y después probaron la red neuronal con el último 10 por ciento para comprobar su rendimiento con portadas que nunca había visto antes.

Los resultados son interesantes. El algoritmo identificó correctamente el género más del 40% de las veces si disponía de tres opciones de respuesta, e identificó el género exacto más del 20% de las veces. Es significativamente mejor que el azar. “Esto demuestra que es posible clasificar las portadas de los libros, aunque es bastante difícil”, escriben los investigadores.

Algunas categorías son más fáciles de reconocer que otras. Por ejemplo, los libros de viajes y los libros sobre informática y tecnología resultan relativamente fáciles de identificar para la red neuronal porque los diseñadores de libros emplean regularmente imágenes y diseños similares para estos géneros.

La red neuronal también encontró que los libros de recetas resultan fáciles de reconocer si emplean fotos de comida. Pero se vuelven totalmente ambiguos si emplean un diseño diferente como una foto del autor.

Las biografías y memorias también resultan problemáticas, y el algoritmo a menudo las consideraba como libros de historia. De forma interesante, para muchos de estos ejemplares, la historia es el segundo género asignado por Amazon, lo que sugiere que el algoritmo no iba del todo desencaminado.

El algoritmo también confundió libros infantiles con cómics y novelas gráficas además de con libros de medicina y de ciencia. Tal vez también resulta comprensible dadas las similitudes entre estas categorías.

Pero el trabajo contiene un fallo. Iwana y Uchina no han comparado el rendimiento de su red neuronal con la capacidad humana de reconocer el género de los libros por sus portadas. Sería un experimento interesante y resultaría relativamente sencillo de hacer mediante un servicio de crowdsourcing en línea como Mechanical Turk de Amazon.

Hasta que se haga ese trabajo, no existe forma de saber si las máquinas rinden mejor en esta tarea que los humanos. Aunque, al margen de lo bien que se nos de esta tarea a los humanos, seguramente sólo será cuestión de tiempo que las máquinas rindan mejor.

No obstante, es un trabajo interesante que podría ayudar a los diseñadores a mejorar sus capacidades en cuanto a las portadas de libros. Un resultado más probable, sin embargo, es que podría ser empleado para entrenar máquinas para diseñar portadas de libro sin la necesidad de ayuda humana. Y eso significa que el diseño de portadas de libro es tan sólo otro trabajo posicionado para pasar a los libros de historia.

Fuente: technologyreview.es