Olvídate de las noticias falsas, los videomontajes ya están aquí

La escena inició en una habitación con un sofá rojo, una planta en una maceta y el tipo de arte moderno insulso que verías en la pared de un terapeuta.

En el cuarto estaba Michelle Obama, o alguien que lucía exactamente como ella. Usando una blusa escotada con un sostén negro que se veía por debajo, se movía sensualmente frente a la cámara y mostraba su inconfundible sonrisa.

Entonces, la doble de la ex primera dama comenzó a desvestirse.

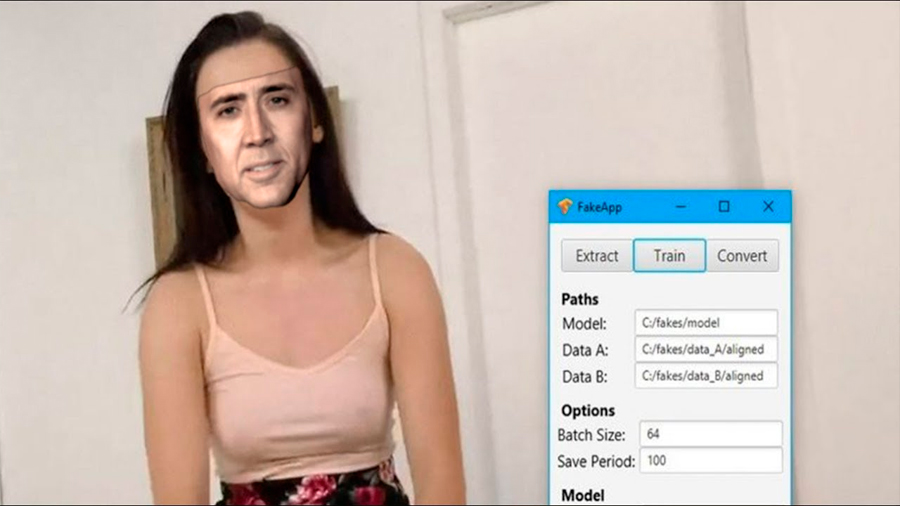

El video, que apareció en el foro de internet Reddit, era lo que se conoce como un deepfake: un videomontaje ultrarrealista hecho con software de inteligencia artificial. Se creó utilizando un programa llamado FakeApp, que sobrepuso el rostro de Obama en el cuerpo de una actriz de películas pornográficas. El híbrido era espeluznante: de no estar bien enterado, podrías haber pensado que de verdad era ella.

Hasta hace poco, los videos realistas generados por computadora eran un formato laborioso que solo estaba disponible para las producciones hollywoodenses con grandes presupuestos o investigadores de punta. Aplicaciones de redes sociales como Snapchat incluyen algunas tecnologías rudimentarias para transformar el rostro.

Sin embargo, en meses recientes, una comunidad de aficionados ha comenzado a experimentar con herramientas más poderosas, entre ellas FakeApp, que creó un desarrollador anónimo utilizando software de código abierto escrito por Google. FakeApp hace que sea gratis y relativamente fácil crear transformaciones faciales realistas y dejar pocos rastros de manipulación. Según su creador, desde que apareció una versión de la aplicación en Reddit en enero, se ha descargado más de 120.000 veces.

Los videomontajes son una de las formas más nuevas de manipulación digital, y una de las más susceptibles a utilizarse para difamar a políticos, crear pornografía vengativa o tender trampas a las personas para culparlas de crímenes. Los legisladores estadounidenses han comenzado a preocuparse por la manera en que esos videos podrían usarse como sabotaje político y propaganda.

Incluso en sitios moralmente laxos como Reddit, los videomontajes han dejado perpleja a la gente. Hace poco, FakeApp desató pánico después de que el sitio de tecnología Motherboard informó que la gente lo estaba usando para crear videos pornográficos falsos de celebridades. Pornhub, Twitter y otras páginas rápidamente prohibieron los videos, y Reddit cerró algunos grupos de deepfakes, entre ellos uno con casi 100.000 miembros.

Antes de que se clausuraran, los grupos en Reddit tenían una mezcla de usuarios que intercambiaban consejos de edición de video y mostraban sus falsificaciones más recientes. Una publicación titulada “Reconstrucción 3D para ángulos adicionales” estaba al lado de videos con títulos como “(No es) Olivia Wilde tocándose”.

Algunos usuarios de Reddit defendieron los videos y culparon a los medios por exagerar su potencial de daño. Otros subieron sus videos a plataformas alternativas, anticipándose al cierre de esos grupos en Reddit debido a sus reglas en contra de la pornografía no consensuada. Además, algunos expresaron dudas morales acerca de difundir esta tecnología… Después, siguieron haciendo más.

Crear los videomontajes

Después de explorar durante semanas la comunidad de videomontajes en Reddit, decidí ver cuán fácil era crear uno (no pornográfico, sino apto para todo público) utilizando mi propio rostro.

Comencé descargando FakeApp y colaborando con dos expertos técnicos para que me ayudaran. El primero fue Mark McKeague, un colega en el departamento de desarrollo e investigación de The New York Times. El segundo fue un creador de videomontajes que encontré en Reddit y utiliza el alias Derpfakes, debido a la naturaleza controvertida de los videos.

Derpfakes comenzó a publicar videos falsos en YouTube hace unas semanas, especializándose en clips humorísticos, como uno en el que Nicolas Cage interpreta a Superman. La cuenta también ha publicado algunos videos tutoriales acerca de la creación de esos videos.

Aprendí que no es sencillo hacer un deepfake. Elegir la fuente de datos adecuada es crucial. Los videos cortos son más fáciles de manipular que los largos, y las escenas filmadas con un solo ángulo dan mejores resultados que las grabadas con ángulos múltiples. La genética también ayuda. Cuanto más se parezcan los rostros, mejor.

Soy un hombre de cabello castaño y uso barba corta, así que Mark y yo decidimos probar con otros hombres blancos de cabello castaño con barba. Comenzamos con Ryan Gosling (hay que apuntar a lo más alto, ¿no?). También le envié a Derpfakes, mi experto externo de Reddit, varias opciones de videos para elegir.

A continuación, tomamos cientos de fotos de mi rostro y reunimos las imágenes del rostro de Gosling utilizando un video reciente de una aparición en televisión. FakeApp utiliza esas imágenes para entrenar al modelo de aprendizaje profundo y enseñarle a imitar nuestras expresiones faciales.

Para obtener la gama de fotografías más amplia, giré mi cabeza en distintos ángulos e hice tantos gestos distintos como pude.

Mark después utilizó un programa para recortar esas imágenes y dejar solo nuestros rostros; eliminó manualmente cualquier fotografía borrosa o mal recortada. Después subió las tomas en FakeApp. En total, utilizamos 417 fotografías mías y 1113 de Gosling.

Cuando las imágenes estuvieron listas, Mark presionó “Comenzar” en FakeApp y el entrenamiento comenzó. La pantalla de su computadora se llenó de imágenes de mi rostro y del de Gosling, mientras el programa intentaba identificar patrones y similitudes.

Casi ocho horas después, después de que nuestro modelo se entrenó lo suficiente, Mark utilizó FakeApp para terminar de poner mi rostro en el cuerpo de Gosling. El video era borroso y extraño, y el rostro de Gosling a veces podía entreverse. Solo las personas legalmente ciegas confundirían conmigo a la persona del video.

Nos fue mejor con un video de Chris Pratt, la estrella desaliñada de Jurassic World, cuyo contorno facial es un poco más similar al mío. Para esta prueba, Mark utilizó un un conjunto de datos más amplio —1861 fotografías de él y 1023 mías— y dejó que el modelo se ejecutara durante toda la noche.

Algunos días después, Derpfakes me envió un video que había hecho utilizando el material que le envié y un video del actor Jake Gyllenhaal. Ese era mucho más realista, un verdadero híbrido que mezclaba mis rasgos faciales con su cabello, su barba y su cuerpo.

Lo que dice el creador de la aplicación

Después del experimento, me comuniqué con el creador anónimo de FakeApp a través de una dirección de correo electrónico en su sitio. Quería saber cómo se sintió crear una innovadora herramienta de inteligencia artificial solo para que fuera usada por los creadores de pornografía.

Un hombre me respondió, identificándose como un desarrollador de software en Maryland. Como Derpfakes, el hombre no me dio su nombre completo, y en vez de eso escribió su primera inicial: N. Dijo que había creado FakeApp como un experimento creativo y le molestó cuando vio que la comunidad de Reddit la utilizó para hacer daño.

“Me uní a la comunidad creada alrededor de esos algoritmos cuando era muy pequeña (menos de 500 personas)”, escribió, “y, en cuanto vi los resultados, supe que era una tecnología brillante que debía ser accesible para cualquiera que quisiera jugar con ella. Decidí que intentaría reunir un paquete fácil de usar para lograrlo”.

N. dijo que no apoyaba el uso de FakeApp para crear pornografía no consensual ni otros contenidos abusivos. Además, agregó que estuvo de acuerdo con la decisión de Reddit de prohibir los videos explícitos. Sin embargo, defendió el producto: “He pensado mucho al respecto y al final decidí que no creo que esté bien condenar la tecnología en sí, puesto que, desde luego, puede usarse para muchos propósitos, negativos y positivos”.

‘La siguiente forma de comunicación’

El día del tiroteo en la escuela en Parkland, Florida, una impresión de pantalla de un artículo noticioso de BuzzFeed titulado “Por qué necesitamos quitarles las armas a las personas blancas ahora más que nunca”, escrito por un reportero llamado Richie Horowitz, comenzó a compartirse en las redes sociales.

Todo era falso. No existe ningún empleado de BuzzFeed llamado Richie Horowitz y jamás se publicó un artículo con ese título en el sitio. Sin embargo, la imagen alterada provocó la indignación de medios de la derecha y fue impulsada por activistas en Twitter. No era un videomontaje generado con inteligencia artificial ni una transformación particularmente sofisticada en Photoshop, pero funcionó.

La desinformación en internet, sin importar qué tan buena producción tenga, se divulga a través de un proceso familiar una vez que entra a nuestros canales de distribución en las redes sociales. El engaño se comparte 50.000 veces; la publicación que lo desmiente una hora después solo se comparte 200 veces. La información falsa recibe un impulso algorítmico en servicios como Facebook y YouTube, mientras que los expertos dan gritos que llegan al vacío.

No hay motivo para creer que los videomontajes operarán de manera distinta. La gente los compartirá cuando sean ideológicamente convenientes y los ignorarán cuando no sea así. Los incautos que se creen las historias satíricas de The Onion también serán engañados por los deepfakes, y la gente escrupulosa que se preocupa por la verdad encontrará maneras de detectarlos y desmentirlos.

Por eso estoy aquí, diciéndoles esto: ya existe un programa con el poder suficiente para convertir a Michelle Obama en una estrella pornográfica o transformar a un columnista descuidado y un poco pasado de peso en Jake Gyllenhaal. Los videos manipulados pronto se harán mucho más comunes.

Probablemente no haya nada que podamos hacer más que intentar combatir los engaños cuando salgan a la luz, ejercer presión sobre las empresas de redes sociales para que luchen agresivamente contra la desinformación y confiar en nuestros ojos un poco menos cada día.

Fuente: NYT