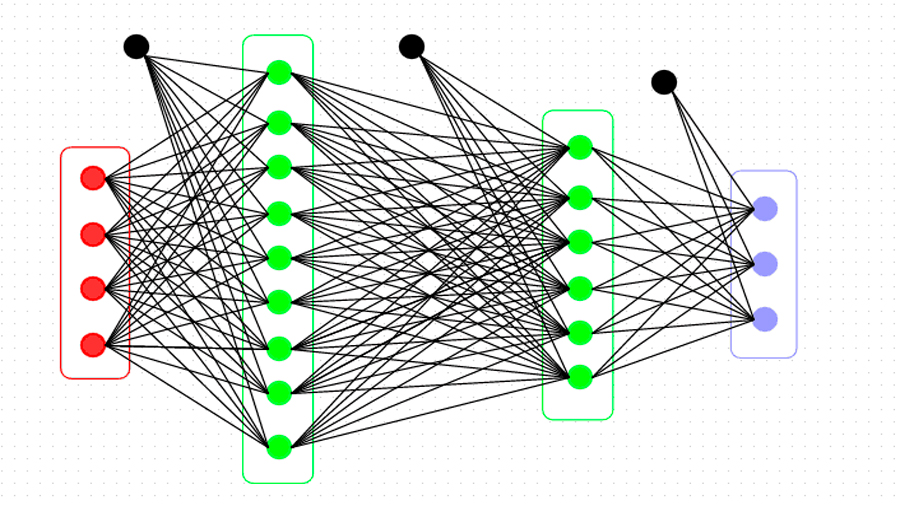

Drástico recorte al tiempo de entrenamiento preciso de redes neuronales

Una nueva técnica para entrenar máquinas de inteligencia artificial (IA) ha reducido a menos de la mitad el tiempo requerido para este propósito manteniendo el nivel de precisión.

Durante el experimento, el equipo de la Universidad Baptista de Hong Kong (HKBU) y Tencent Machine Learning entrenó dos conocidas redes neuronales profundas llamadas AlexNet y ResNet-50 en solo cuatro minutos y 6,6 minutos respectivamente. Anteriormente, el tiempo de entrenamiento más rápido era 11 minutos para AlexNet y 15 minutos para ResNet-50.

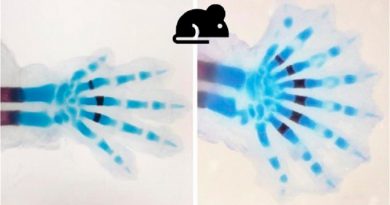

AlexNet y ResNet-50 son redes neuronales profundas creadas en ImageNet, un conjunto de datos a gran escala para el reconocimiento visual. Una vez entrenado, el sistema pudo reconocer y etiquetar un objeto en una foto determinada. El resultado es significativamente más rápido que los registros anteriores y supera a todos los demás sistemas existentes.

El aprendizaje automático es un conjunto de enfoques matemáticos que permiten a las computadoras aprender de los datos sin que los humanos los programen explícitamente. Los algoritmos resultantes se pueden aplicar a una variedad de tareas de reconocimiento visual y de datos utilizadas en la IA.

Chu Xiaowen, profesor de la HKBU involucrado en el estudio, dijo en un comunicado: “Hemos propuesto un nuevo método de entrenamiento optimizado que mejora significativamente la velocidad sin perder precisión. En el entrenamiento de IA, los investigadores se esfuerzan por entrenar sus redes más rápido, pero esto puede llevar a una disminución en la precisión. Como resultado, el entrenamiento de los modelos de aprendizaje automático a alta velocidad, al mismo tiempo que mantienen la precisión y la precisión, es un objetivo vital para los científicos “.

El profesor Chu dijo que el tiempo requerido para entrenar las máquinas de IA se ve afectado tanto por el tiempo de computación como por el tiempo de comunicación. El equipo de investigación logró avances en ambos aspectos para crear este logro récord.

Esto incluyó la adopción de un método computacional más simple conocido como FP16 para reemplazar al más tradicional, FP32, lo que hace que el cómputo sea mucho más rápido sin perder precisión. Como el tiempo de comunicación se ve afectado por el tamaño de los bloques de datos, el equipo creó una técnica de comunicación llamada “tensor fusion”, que combina fragmentos más pequeños de datos en otros más grandes, optimizando el patrón de transmisión y mejorando así la eficiencia de la comunicación durante el entrenamiento de IA. .

Esta nueva técnica se puede adoptar en la clasificación de imágenes a gran escala, y también se puede usar en otras aplicaciones de inteligencia artificial, incluida la traducción automática; procesamiento del lenguaje natural (PNL) para mejorar las interacciones entre el lenguaje humano y las computadoras; análisis de imágenes médicas; y juegos de combate multijugador en línea.

Fuente: europapress.es